今天要开一个深坑了,最早在三四月份做相关产品的时候,就有大佬跟我说,节点式生成的ComfyUI解决了很多webUI蛋疼的一些交互和逻辑,未来可期,让我留意,当时很是认可,但也一直没空研究。

直到SD发布了XL1.0后,ComfyUI再次用它优秀的底层逻辑率先打击了臃肿不稳定的WebUI1.6,成为更适合“体验”XL的SD生图工具。如果要给这个“体验”定义更严格生产一些的话,那可以说是最佳工具,没有之一。

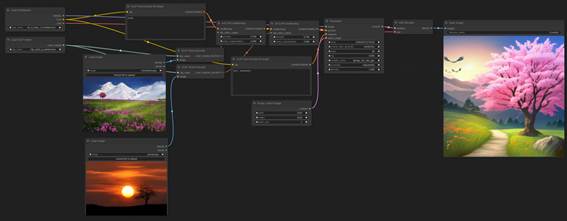

但在与大家一起努力学习,了解了ComfyUI后,我有点难以抑制的激动,我觉得之前称呼这个“开启XL大门的钥匙”有些欠妥,它应该是开启AIGC新世 ...

今天要开一个深坑了,最早在三四月份做相关产品的时候,就有大佬跟我说,节点式生成的ComfyUI解决了很多webUI蛋疼的一些交互和逻辑,未来可期,让我留意,当时很是认可,但也一直没空研究。

直到SD发布了XL1.0后,ComfyUI再次用它优秀的底层逻辑率先打击了臃肿不稳定的WebUI1.6,成为更适合“体验”XL的SD生图工具。如果要给这个“体验”定义更严格生产一些的话,那可以说是最佳工具,没有之一。

但在与大家一起努力学习,了解了ComfyUI后,我有点难以抑制的激动,我觉得之前称呼这个“开启XL大门的钥匙”有些欠妥,它应该是开启AIGC新世界大门的钥匙!

所以决定,这个坑要挖了,且毅然决然的往里跳了。在过去的一周中,我已经用ComfyUI平替掉了大部分WebUI的生图工作。还卖掉了12G显存的3060,只留了一台8G的3070,使用ComfyUI+云端SD完全够了。还新获得了很多有如魔法一般的工作流(指的是ComfyUI's workflow),这让我对扩散模型进行aigc有了新的认知。所以以后应该也会是ComfyUI作为创造主力C,WebUI打野辅助,MJ中单负责GANK,我给他们包鸡包眼,端茶送水付电费就好。

我已经迫不及待的想把它安排(li)给你们了。

可以选择的新世界

至于很多人跟我一样,觉得密密麻麻有如电路板一样的操作界面太劝退了,我这两天在学习的过程中思考了一下,我准备之后的文章都会提供2套思路,分别是:

1.🤔A航线有webui的底子,想了解生图过程,能举一反三,进阶学习的。

2.🤓B航线喂饭都不想吃,我只想无脑使用,出图效果好的。

如果跟随《Stable

Diffusion 防災指南》一路学习过来的朋友可以选择A航线继续跟随卡爷的节奏进入ComfyUI新世界,而对ComfyUI本身兴趣不大,但对比WebUI还简单无脑的生图很需要,直接跳过下面A部分,滑到后面的B航线就行,按需食用即可。

▍第一次生成(A航线🤔)

在进行ComfyUI的第一次生成前还是有很多准备工作的,考虑走A航线的大家已经是AI栋梁了,就不再像以前一样喂饭了,不过我们还是需要先基本了解一下:

§ComfyUI是什么

§如何在本地安装ComfyUI

§一次基本生成(txt2img)的工作原理(尤为重要)

§进行一次基本生成

1. ComfyUI

A powerful and modular stable diffusion

GUI and backend(一个强大的、模块化的Stable

Diffusion GUI和后端)作者是这么开场白的。

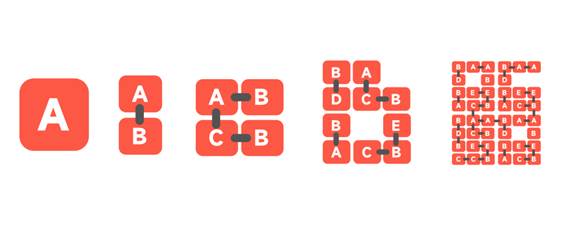

ComfyUI主要使用基于图形/节点/流程图的界面来设计和执行进阶的SD管线。所以我们可以简单的理解过去我们在webui中一个按钮和几个设置操作的工作部分,需要在ComfyUI中进行workflow的连接。而SD在整个扩散生成的过程,每一个工作环节都将颗粒度变小,最小单位是一个或者多个参数组成一个节点块。多个节点块构成一个生成步骤。多个生成步骤拼起来是一次任务,而若干个任务就能解决无穷无尽的需求了。

就好像从蛋白质形成细胞,到器官,到人体,人体组成家庭,家庭构建社会...一样可以进行更多的组合,这里就充满了创造和想象,这也是ComfyUI领先于WebUI的逻辑所在。一会在工作原理上会再详细介绍。

这样你大概率可以完成这样你在webui想都不敢想的操作:

官方的特征介绍(我把主要的列出来):

节点/图形/流程图界面,用于实验和创建复杂的稳定扩散工作流程,而无需编写任何代码。

完全支持 SD1.x、SD2.x 和 SDXL

异步队列系统

仅重新执行在执行之间更改的工作流部分(节省计算资源)

甚至可以使用cpu进行生图(很慢),可以在小于3G显存的GPU上运行

可以加载 ckpt、安全张量和扩散器模型/检查点。独立的VAE和CLIP型号。

嵌入/文本反转

从生成的 PNG 文件加载完整的工作流(带有种子)。

将工作流保存/加载为 JSON 文件。

启动速度非常快。

完全离线工作:永远不会下载任何内容。

设置模型搜索路径,可以复用设备上的其他路径里的模型文件。

2. 安装

直接下载官方提供了一个window版的解压即用,(像不像懒人包?就是),复制下面链接即可下载,大小1.35G(不含模型),版本121.

https://github.com/comfyanonymous/ComfyUI/releases/download/latest/ComfyUI_windows_portable_nvidia_cu121_or_cpu.7z手动部署需要先确认python安装(有webui这里应该都有装好),pytorch(注意:pytorch 尚不支持 python 3.12,因此请确保您的 python 版本为 3.11 或更早版本)

git

克隆comfyui到本地。打开windows的cmd,然后输入下面:

·

git clone https://github.com/comfyanonymous/ComfyUI.git

至于如何安装pytorch,以及Linux,Mac OS如何安装,受限篇幅,我就不多废话,上面clone的地址上有详细说。

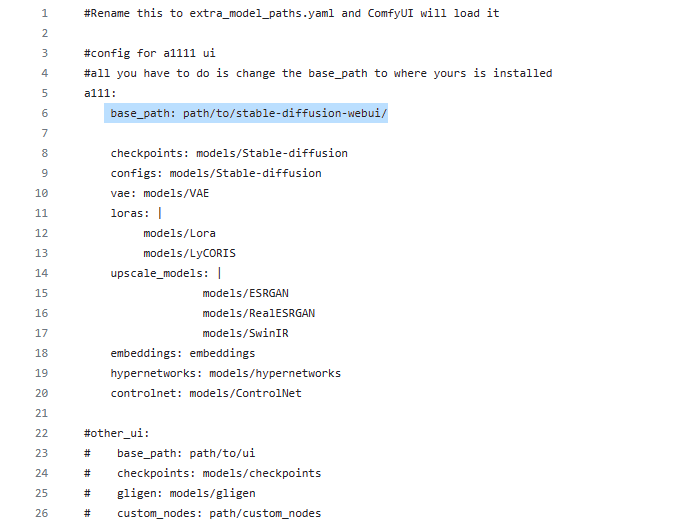

所以综合来看,ComfyUI在部署上其实比WebUI反而更容易。修改配置-使用WebUI的模型共享上面特性有介绍设置模型搜索路径,可以复用设备上的其他路径里的模型文件。你只需要部署好ComfyUI后进入文件夹中找到下面这个文件。(记事本打开,也可以把.example删掉再打开)

ComfyUI/extra_model_paths.yaml.example

把base_path: 后面改成你webui的根目录就行。

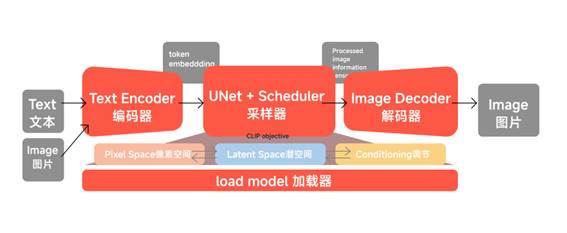

3. 一次T2I的工作原理*

这部分很重要,这部分是使用好ComfyUI的核心,可以说是基本功,只要了解了扩散模型的工作原理,你才能自己拼装出来能应付所有需求的工作流。

先倒退回最早学习SD扩散模型的理论知识(现在回想起来,当初可能真的是学了个寂寞啊,文章也是囫囵吞枣,重点还是看引用链接吧)传送门:

Stable

Diffusion的工作原理(理论篇)

我基于自己的理解重新做了一张更好消化的原理流程图。里面红色部分也是ComfyUI的节点重要组成部分,就像乐高的基础模块了。

编码器(Encoder):文本也好,图片也好都需要经过一个编码器才能变成机器认识的语言。尤其是图片,与文本的编码不一样,这个我们图生图再说。

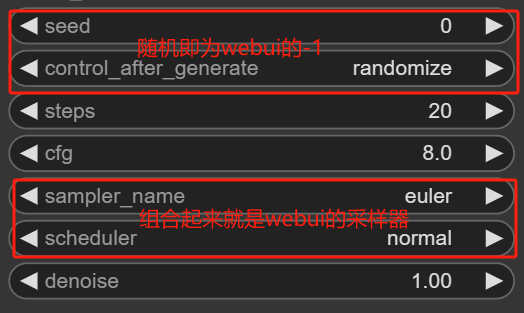

采样器:这里名词不是很严谨,但为了方便你学习ComfyUI,你就把带有算法,在潜空间一顿操作的玩意儿叫采样器,图片尺寸,采样步数,采样算法,潜空间种子等一系列的设置也都在这部分完成。

解码器:经过潜空间操作之后变成噪点的这一堆玩意儿,还需要一个解码器才能重新变成图片。

加载器:这是为了工具而设立出来的一个东西,因为模型我们需要有个盘子装起来,所以需要加载checkpoints,lora,controlnet模型,甚至图片,在comfyui里都统称加载器。

整个原理有个不恰当的比喻就是:

就像你虚着眼睛看一张图,这个图在潜空间里重新一顿洗牌,码牌,等你把眼镜一带,哇,图生出来了!

4. 进行一次基本生成

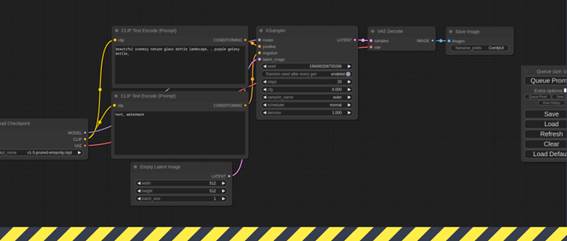

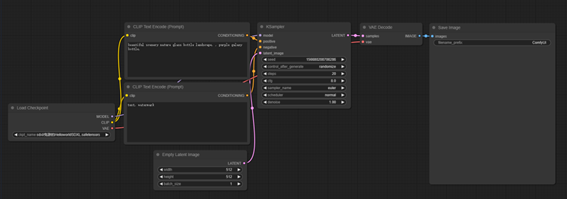

好了,4个器皿你都get到了。这个时候我们再打开ComfyUI,这下默认的这个组合你就很容易认识了。

如果没有默认工作流,可以从B航线窃取,ComfyUI官方特性就提到了最好用的“拿来主义”,也是B航线能成立的原因。

如果你对于不是中文有些苦恼,也没关系,先认识这几个单词也没坏处,之后会在插件那期专门提供汉化插件的安装。

最后,就只需要选择需要的模型,随便设置一下熟悉的参数,在正向关键词里填入你想要描述的英文prompt。点击默认在右边dock住的菜单栏上的queue prompt按钮。(快捷键Ctrl+Enter)

你会目送,程序从加载器开始加载模型,快速的clip编码进入采样器开始跑进度条,最后从解码器解码出来放入保存的图片容器中。

你ComfyUI的Hello world 就!!了。

▍第一次生成(B航线🤔)

B航线就不用动脑子了,也不用管ComfyUI怎么工作的,最多先进行一次安装,如果安装都不想做,你可以更我一样选择在线云,打开浏览器就能使用comfy。

安装

复制下面链接,你就获得一个纯净的官方comfyUI。老样子,我也会在文末提供网盘下载。至于手动部署就算了,太复杂。

https://github.com/comfyanonymous/ComfyUI/releases/download/latest/ComfyUI_windows_portable_nvidia_cu121_or_cpu.7z

导入工作流or图片

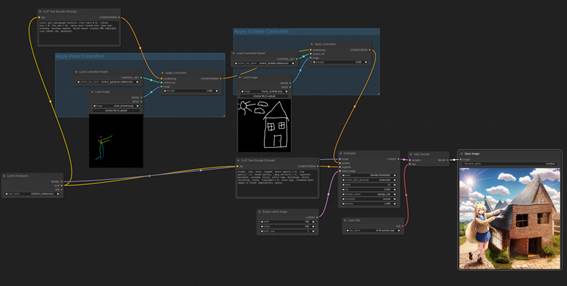

第一次进入你大概看到这样一次生成,如果不是也没关系,不用自己重新连接一遍。只需要把我下面这张图片拖拽进入ComfyUI中,你就会获得这个图片生成的完成工作流(包含使用模型,prompt,参数,种子,甚至节点布局都是像素级的还原。)

微信压缩了图,你大概率要从下载中获得原始图片和工作流的json文件。

傻瓜式操作

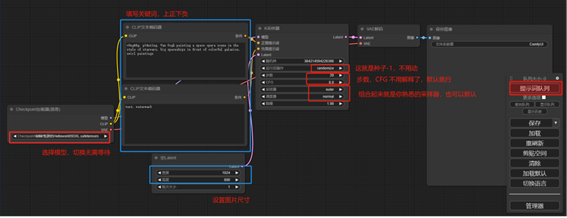

将工作流or图片导入后,看下图,你只需要操作:

·选择模型。(可默认)

·填写关键词(负面关键词可以默认)

·设置图片尺寸。(默认512x512)

·设置图片参数(捷克默认)

·点击最右边的第一个按钮,就可以目送你的图片从左到右的进行生成工作了。

全程甚至只需要填写正向关键词这一步操作就行,和webui一样,比webui还流畅,还直观,甚至更简单的生成动作。

中文设置

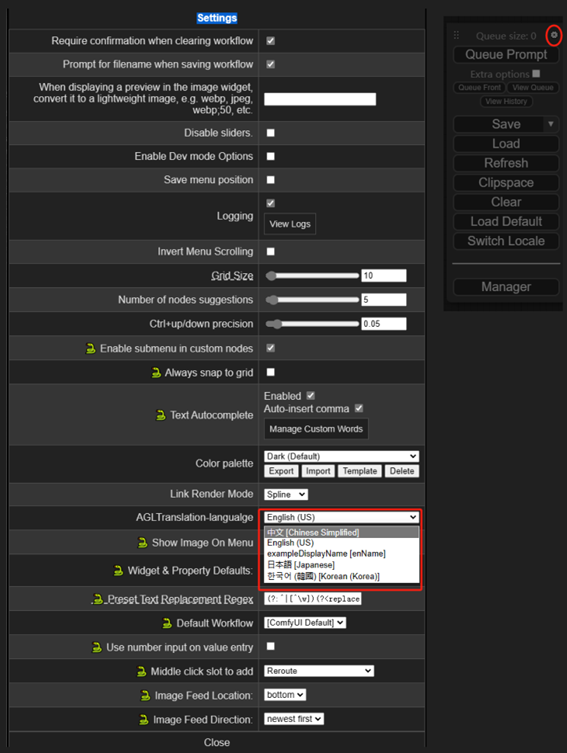

使用暴躁鱼干在线云学习使用ComfyUI的只需要在生图控制台右上角点击设置⚙图标,然后在设置菜单中找到语言设置,切换成中文就行。

没用使用暴躁鱼干在线云的暂时不要着急我们后续插件篇会提到如何安装UI汉化插件的。

好了,AB航线都启航了,万事开头难,ComfyUI这个头还是比使用14篇基础知识堆砌而出来的WebUI开端-防灾指南要容易得多了。

出自:https://mp.weixin.qq.com/s/PdmsHXNesYesHapVlzkerw

本文档由网友提供,仅限参考学习,如有不妥或产生版权问题,请联系我们及时删除。

客服请加微信:skillupvip