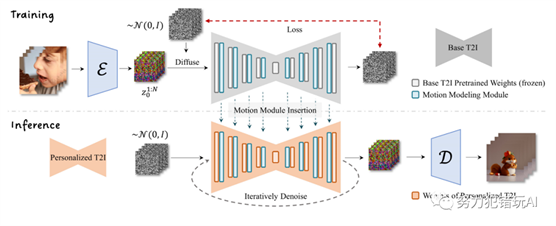

AnimateDiff通过控制模块优化Stable Diffusion模型,利用短视频剪辑训练生成相似图像序列,确保视频帧流畅。与传统SD模型训练不同,AnimateDiff通过短视频训练提高图像连续性,生成高质量短视频。

AnimateDiff介绍

AnimateDiff采用控制模块来影响Stable Diffusion模型,通过大量短视频剪辑的训练,它能够调整图像生成过程,生成一系列与训练视频剪辑相似的图像。简言之,AnimateDiff通过训练大量短视频来优化图像之间的过渡,确保视频帧的流畅性。

与传统的SD模型训练方式不同,AnimateDiff通过大量短视频的训练来提高图像之间的连续性,使得生成的每一张图像都能经过AnimateDiff微调,最终拼接成高质量短视频。

官方视频效果

安装

使用 AnimateDiff 需要安装 SD 插件和 AnimateDiff 模型。

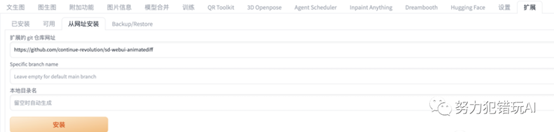

SD插件安装

如果能科学上网,可以直接在扩展->从网址安装中填入

https://github.com/continue-revolution/sd-webui-animatediff.git

如果没办法通过网站安装,公众号回复 animatediff 获取下载链接。

模型下载

安装好插件之后,将 AnimateDiff

模型下载放到 stable-diffusion-webui/extensions/sd-webui-animatediff/model/

下载链接:https://huggingface.co/guoyww/animatediff

如果无法下载,公众号回复 animatediff 获取下载链接,找到 mm_sd_v15_v2.ckpt 放到本地的目录中即可。

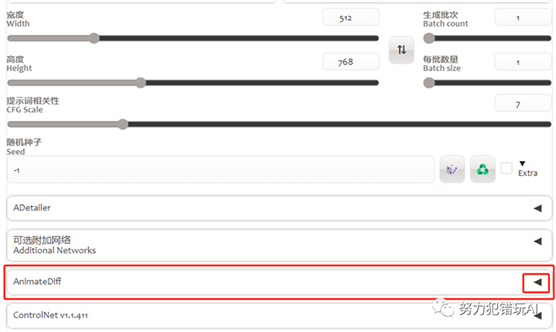

安装成功之后,重启 Stable

Diffusion,在文生图页面可以看到 AnimateDiff 插件配置。

参考资料

github

https://github.com/guoyww/animatediff/

论文

https://arxiv.org/pdf/2307.04725.pdf

sdwebui官方

https://github.com/continue-revolution/sd-webui-animatediff

出自:https://mp.weixin.qq.com/s/K7eWwxcPeUDggt9P6A9UcQ

本文档由网友提供,仅限参考学习,如有不妥或产生版权问题,请联系我们及时删除。

客服请加微信:skillupvip