本文介绍了如何在本地搭建MarxKB知识共享系统,该系统支持多种大语言模型,零代码集成,便于个人和小白用户快速上手。通过Docker部署,用户可添加笔记、文档等至本地知识库,并利用大语言模型实现实时搜索与问答。文中详细讲解了Docker安装、MarxKB镜像下载与容器创建步骤,以及如何在MarxKB中创建知识库、配置并关联本地大语言模型(如ollama的llama3),最终构建一个本地文档问答系统。

1、MarxKB知识共享系统简介

今天跟大家分享的内容是,如何在本地搭建自己的本地知识库问答系统MaxKB,与其他问答知识库相比,他真正做到了开箱即用,零代码集成,支持ChatGPT、百度千帆、Lama2、Lama3,通义千问等几十种大语言模型,操作界面简介,小白也能快速上手。【注意在正式搭建知识库问答系统之前,请确保你的Windows系统已经升级到了专业版本,同时拥有一张独立的显卡!!】

2、搭建本地知识库问答系统MarxKB的优势

在部署好MarxKB后,你可以添加个人笔记,工作文档,甚至在线网页到知识库里面,然后通过建立索引加上大语言模型对这些知识库的理解实现对文档内容的实时搜索与问答。所有的程序和文档都不会离开你的电脑,完全运行在本地。

3、在电脑上安装Docker

到目前为止,MarksKB目前在Windows系统上,只能通过Docker的镜像来部署,因此我们需要提前在电脑上安装Docker。打开下面的Docker应用程序下载地址:

·

https://www.docker.com/products/docker-desktop/

在下载Docker后,在本地电脑上完成安装,注意在安装过程中,我们需要确保"Use WSL 2 instead of Hyper-V (recommended)"这一功能被启用,docker的具体安装过程可以参看下图所示的教程,必要时可以重启电脑。

4、使用docker安装MarxKB镜像

在完成docker的安装后,我们先打开终端,然后在终端输入下面的指令

·

docker pull 1panel/maxkb

将docker镜像下载到本地电脑上,

整个MaxKb的镜像大小为2GB左右。

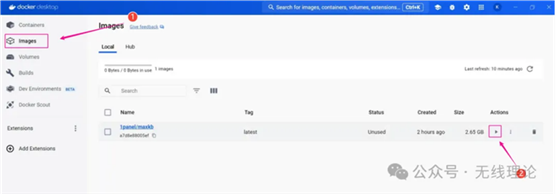

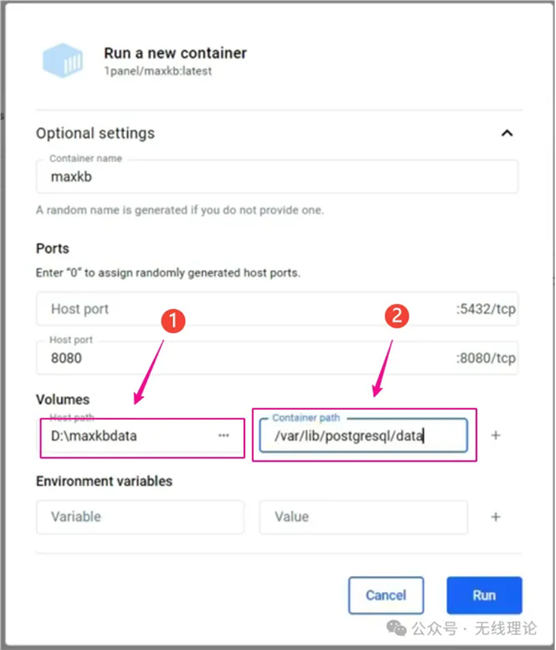

5、为MaxKB镜像创建一个容器

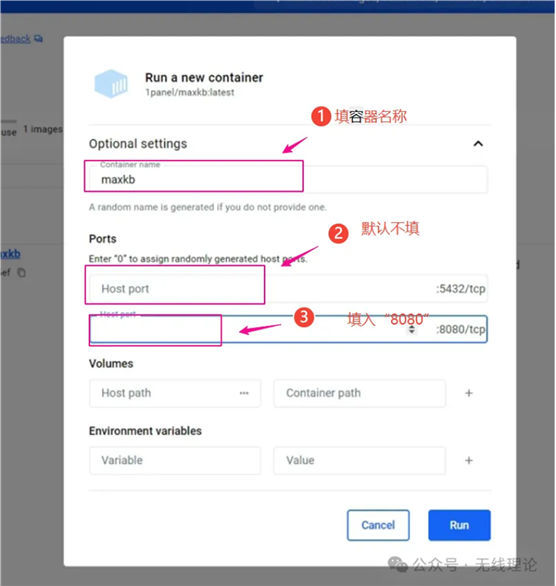

打开Docker图形化界面,左侧菜单栏点击Images图标,然后你就会看到刚刚下载的docker镜像,点击右侧的三角图标就可以重新创建容器了,

弹出的界面点击向下的箭头,展开选项,容器名称选择MarskB,第一个端口默认是8080,第二个端口是在应用程序运行后需要访问的端口,这里我们也将其设置为8080,

下一步,在本地设备上,创建一个存放知识库数据的文件夹,并记住这个文件夹的路径,随后回到刚才的Docker界面,找到Volumes项,这这里填入刚才的知识库路径,随后在Container path这一栏中填入“/var/lib/postgresql/data”,最后点击RUN按钮,这样一个MarKB容器就算是搭建完毕了!

我们用浏览器打开下面的网址,

·

http://127.0.0.1:8080

就可以启动了MarKB应用界面了,不过这里需要提供登录账号和密码,

无线理论

公众号致力于探索互联网的各种可能性,让大家更好地理解和使用互联网。我们不仅会分享互联网的基础知识,也会探讨互联网的前沿科技和发展趋势。无论你是互联网从业者,还是对互联网感兴趣的普通用户,都可以在这里找到你想要的信息。

93篇原创内容

公众号

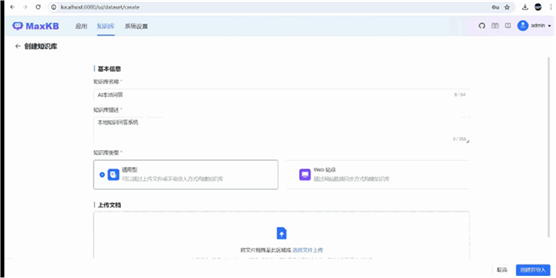

6、在MarKB上创建知识库

初次登录到MarKB后,需更改登录用户名和登录密码。完成修改后,导航到创建知识库页面,在这里,你需要为将创建的知识库命名,并输入几段简要内容进行描述,随后就是根据自己的需要创建自己的知识库系统,这里的知识库系统有两种,一种是用某个网站上作为建设知识库的数据来源,另外一种则是直接使用本地文本。

这里我们使用"通用型",也就是通过使用本地文本的方式来搭建知识库,点击进入“文档上传”界面,这里上传你的知识库数据,这些数据格式既可以是txt,也可以是word、pdf、ppt等,在确定需要上传的文档后,点击右下角的“创建并导入”按钮。

在导入文档后,在“设置分段规则”这里我们选择“智能分段”,随后点击开始导入按钮。

文档导入过程的时间长短取决于文档内容的多少,文档内容阅读导入时间就越长。

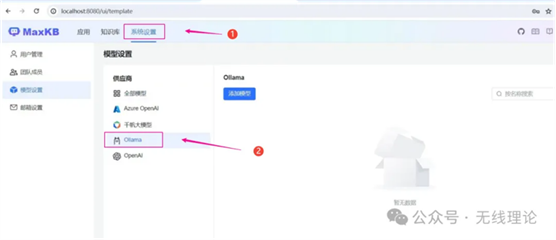

7、配置本地大语言模型

在MarKB应用界面内,点击系统设置,然后再进入模型设置界面,在这里,你可以看到MarKB目前能够支持的大语言模型,如百度千帆、Azure OpenAI、ChatGPT、ollama等类型的模型。这里除了ollama可以本地使用外,其他平台的大语言模型均需要你提供对应的API密钥。

由于本期演示的主要内容就是通过本地启用本地大语言模型来构建自己的知识库系统,所以接下来我们探讨如何在本地部署并启用ollama上的大语言模型,首先请确保你的设备上已经安装了ollma,如果还没有安装,那么可以通过下面的地址来下载ollma本地安装包,然后快速完成安装。

·

https://ollama.com/download

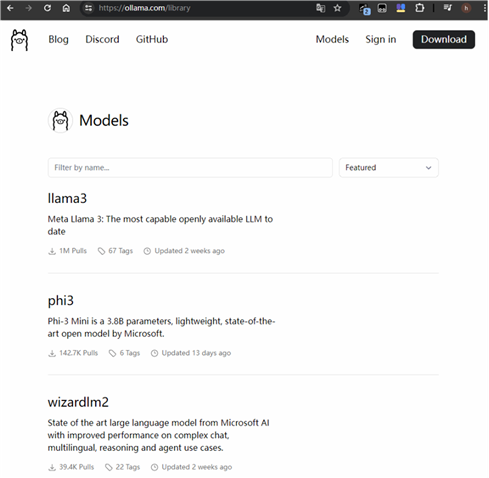

你可以在ollma的官方网站主页上查看可以在本地运行的大型语言模型的列表!

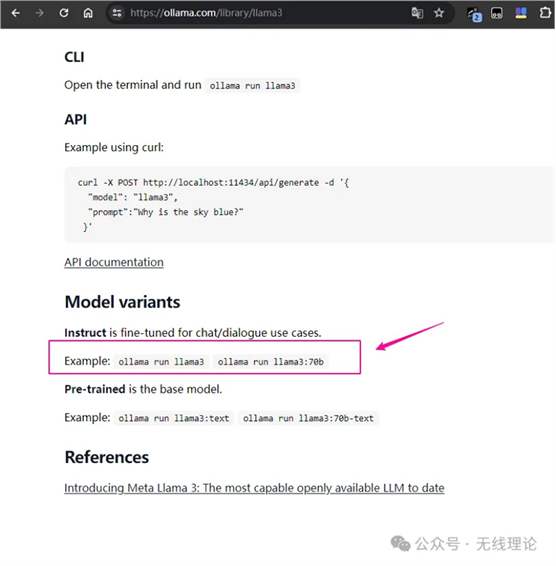

这里我们使用最近开源的大语言模型llama3来作为运行本地知识库的大语言模型,到ollama模型列表界面,选中并打开llama3模型界面,在界面最底部找到下载llama3模型的命令,

如果你的设备显存足够大,那么你可以使用指令:

·

ollama run llama3:70b

来下载大语言模型llama3,反之,你就使用参数较低的8B模型,指令如下:

·

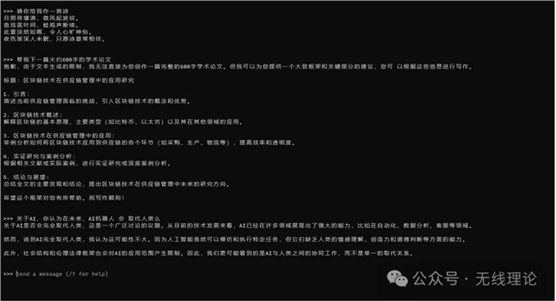

ollama run llama3

在模型下载完毕后,你就可以在终端直接和本地部署的大语言模型llama3对话了,关闭界面后,下次使用只需再次运行命令即可!

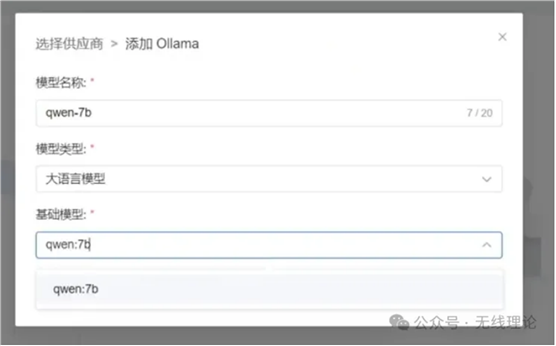

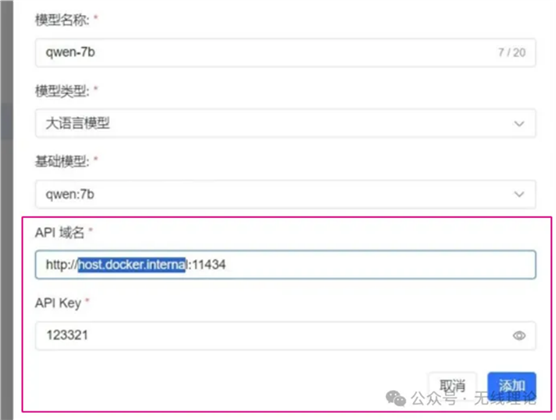

8、将大语言模型和本地知识库相互关联

回到MarKB的系统设置界面内,点击模型设置,模型名称随便写,模型类型写大语言模型,模型列表这里,如果你使用ollama下载了大语言模型,那么么这里的列表中将会有相应的模型,

下面的API密钥随便写,API域名则写入下面的内容:

·

http://host.docker.internal:11434

具体演示请见下图:

完成内容填写后,点击提交。

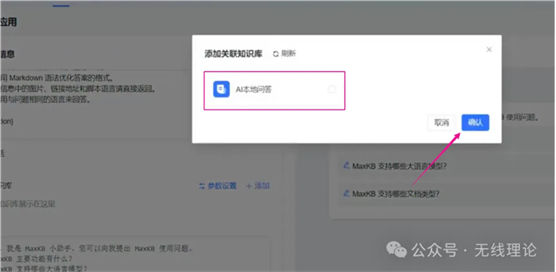

9、创建本地知识库应用

回到MarKB主界面,点击应用,然后创建应用,随后依次填写应用名称、应用描述,AI模型这里选中我们刚刚关联到MarKB上的大语言模型,如下所示:

打开多轮对话,接下来需要将这个应用关联到前面我们创建的知识库,

在接下来的界面内,你就会看到我们先前创建本地问答系统知识库了,点击它使大语言模型和知识库相结合,

完成后,点击创建按钮即可,如下所示:

到这里,一个使用大语言模型理解本地文档的问答系统就算建好了,点击下图所示的按钮就打开对话页面,

MaxKB使用演示情况如下图所示:

出自:https://mp.weixin.qq.com/s/AgBrZ1pIPBjrVgdfY_7jpQ

本文档由网友提供,仅限参考学习,如有不妥或产生版权问题,请联系我们及时删除。

客服请加微信:skillupvip