现在,小白也可以打造专属的智能体了!

达摩院最新出品Agent框架ModelScope-Agent,直接可用可定制。

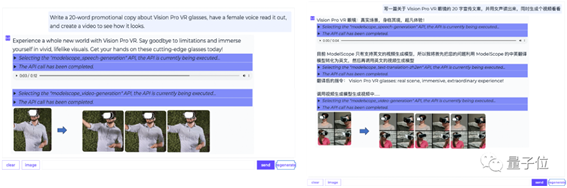

比如,可以同时执行多个工具的规划、调度。

写一篇关于Vision

Pro VR眼镜的20字宣传文案,并用女声读出来,同时生成个视频看看。

也能在多轮对话中持续不同的工具。

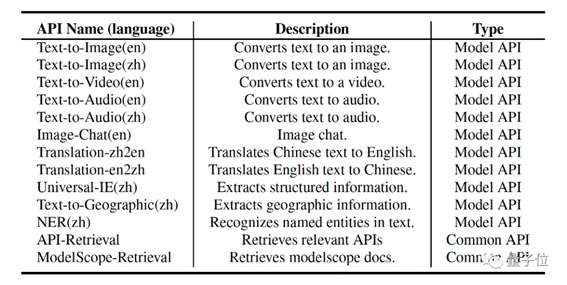

光集成的工具就有这么多,比如NLP、语音、视觉、多模态等多种模型,以及默认集成知识检索、API检索等方案。

在GitHub上还专门提供了详细教程,这就来看看究竟如何构建?

四步构建自己的Agent

1、首先拉取ModelScope-Agent代码并安装相关依赖。

2、配置config文件,ModelScope

token和构建API工具检索引擎。

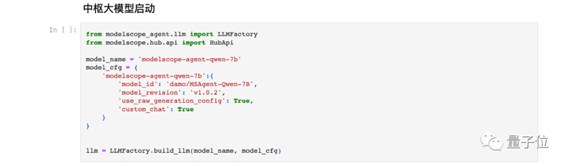

3、中枢大模型启动。

4、Agent构建和使用,依赖之前构建好的大模型,工具list,工具检索和记忆模块。

构建完毕后,还可以注册新工具。GitHub上同样有食用教程。

开发者们可以参考上述教程很容易搭建属于自己的智能体,ModelScope-Agent 依托魔搭社区,未来会适配更多新增的开源大模型,推出更多应用。

如客户服务Agent、个人助理Agent、Story

Agent、Motion Agent、multi-Agent(多模态

Agent)等等。

框架如何设计的?

作为一个通用的、可定制的Agent框架,ModelScope-Agent主要有以下特点:

可定制且功能全面的框架:提供可定制的引擎设计,涵盖了数据收集、工具检索、工具注册、存储管理、定制模型训练和实际应用等功能,可用于快速实现实际场景中的应用。

开源LLMs作为核心组件:支持在 ModelScope 社区的多个开源LLMs上进行模型训练,并开源了配套的中英文工具指令数据集 MSAgent-Bench,用于增强开源大模型作为Agent中枢的规划调度能力。

多样化且全面的API,支持API检索:以统一的方式实现与模型API和常见的功能API进行无缝集成,默认提供开源API检索方案。

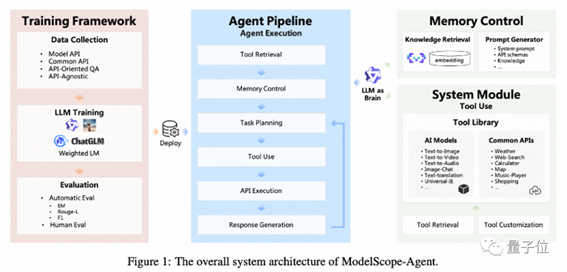

它主要包括这些模块,以开源大语言模型 (LLMs) 为核心,以及记忆控制、工具使用等模块。

开源 LLM 主要负责任务规划、调度以及回复生成;记忆控制模块,主要包含知识检索以及 prompt (提示词)管理;工具使用模块,包含工具库以及工具检索和工具可定制化。

在执行任务时,它会将其拆分成更小的任务,然后一项一项完成。

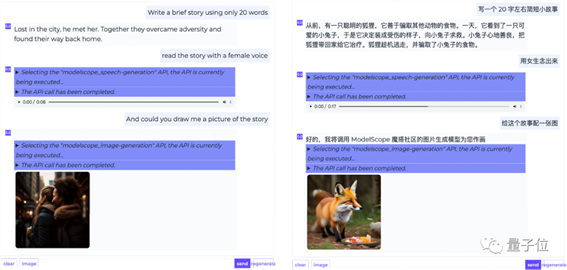

以写一个简短故事,并用女声朗读,同时配个视频”为例。

ModelScope-Agent

会展示整个任务规划过程,先通过工具检索检索相关的语音合成工具,然后由开源 LLM 进行规划调度——

首先生成一段故事,然后调用对应语音生成模型,生成语音并用女声念出,展示给用户,最后再调用视频生成模型,针对生成的故事内容生成一段视频.

这里全程不需要用户配置当前请求可能需要调用到的工具.

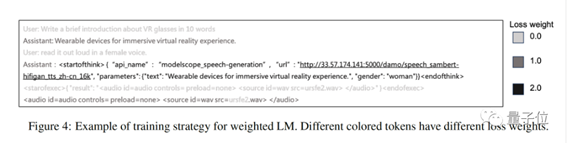

除此之外,他们还提出了新的工具指令微调训练方法:Weighted LM,通过对工具指令调用部分token进行loss加权,提升开源大模型工具指令调用能力。

基于该训练方法和配套的开源中英文工具指令调用数据集MSAgent-Bench,基于Qwen-7B优化训练了MSAgent-Qwen-7B模型,相关数据集和模型都已开源。

论文链接:

https://arxiv.org/abs/2309.00986

代码链接:

https://github.com/modelscope/modelscope-agent

ModelScope体验地址:

https://modelscope.cn/studios/damo/ModelScopeGPT/summary

出自:https://mp.weixin.qq.com/s/Pp7Mu4qR_Z_3AvS2BgBT3A