没想到,OpenAI捞了“竞对”Stable Diffusion一把。

在热火朝天的“AI春晚”上,OpenAI一口气开源两项工作,其中之一一致性解码器,专门面向SD的VAE模型。

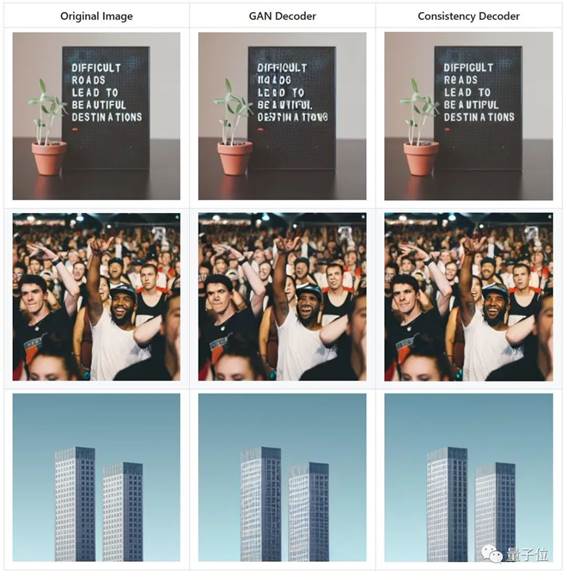

它能让图像生成质量更高、更稳定,比如多人脸、带文字图像以及线条控制方面。

大V博主分析这个解码器应该是Dall·E 3同款,在GitHub项目页上OpenAI也提供了Dall·E 3论文。

它具体支持的版本是Stable Diffusion 1.4/1.5。

项目页上只放了一个例子,具体怎么训练没有写,被网友称为“人狠话不多式开源”。

你们直接加载使用就好。

而且这个一致性解码器颇有渊源。

它来自OpenAI联创及首席科学家Ilya、OpenAI华人新星宋飏等人提出的一致性模型(Consistency Models)。

上半年这个模型开源时就引发业内震动,被评为能“终结扩散模型”。

就在前不久,宋飏等人还对模型训练方法做了优化,能进一步提升图像生成质量。

开发者日的另一项重磅开源是语音大模型Whisper 3。它同样出自传奇人物之手,一作Alec Radford对GPT系列的构建起到了重要作用。

网友们不禁感慨:还是爱看OpenAI开源啊,期待继续开放更多模型。

一致性模型

先来看最初名震江湖的第一版一致性模型(Consistency Models)。

它旨在解决扩散模型通过逐步迭代、导致图像生成缓慢的问题。仅需3.5秒即可生成64张左右256×256的图像。

相比扩散模型,它主要有两大优势:

其一,无需对抗训练(adversarial training),就能直接生成高质量的图像样本。

其二,相比扩散模型可能需要几百甚至上千次迭代,一致性模型只需要一两步就能搞定多种图像任务——

包括上色、去噪、超分等,都可以在几步之内搞定,而不需要对这些任务进行明确训练。(当然,如果进行少样本学习的话,生成效果也会更好)

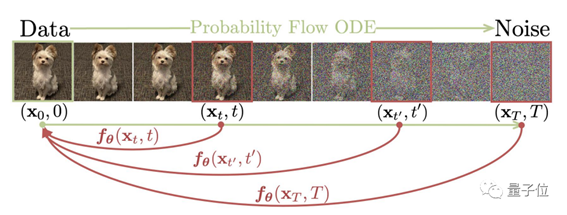

原理上,一致性模型直接把随机的噪声映射到复杂图像上,输出都是同一轨迹上的同一点,所以实现了一步生成。

论文提出两种训练方法,一种是基于一致性蒸馏,利用预训练的扩散模型生成相邻数据对,通过最小化模型输出之间的差异,来训练一致性模型。

另一种方法是独立训练,将一致性模型作为独立生成模型训练。

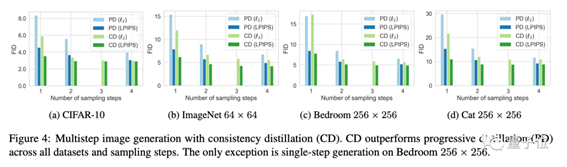

实验结果表明,一致性模型在一步和少步采样方面优于现有的蒸馏技术,如渐进式蒸馏。

当作为独立的生成模型进行训练时,一致性模型可以与现有的一步非对抗生成模型在标准基准测试汇总媲美,如CIFAR-10、ImageNet 64×64和LSUN 256×256。

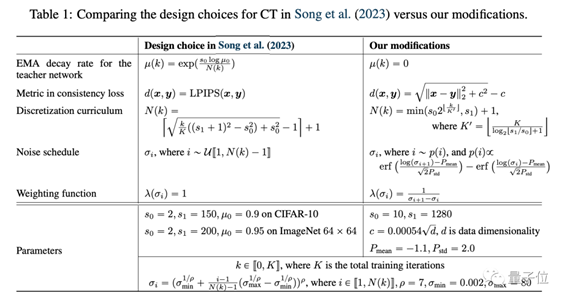

半年后发布的第二版论文,对训练方法进行了优化。

它通过优化权重函数、噪声嵌入和dropout,使得一致性模型在不需要依赖学习过的特征,也能达到很好的生成质量。

它改进了权重函数的选择,使其随着噪声水平的增加而减小,这使得在较小噪声水平处的一致性损失权重更大,从而提升样本质量。

同时调整了噪声嵌入层的敏感性,使其降低对微小噪声差异的敏感性,有助于提高连续时间一致性训练的稳定性。

并且发现了在一致性模型中使用较大dropout、移除teacher network中的EMA、将学习过的特征距离(如LPIPS)替换Pseudo-Huber损失函数,都能能进一步提高图像质量。

OneMoreThing...

回到这次最新开源的解码器,第一波实测体验已经来了。

目前看到的一些效果,提升不算明显,而且不少人反映运行速度慢。

但这还是最早期的测试,后续或许会有更多提升。

值得一提的是,领衔推出一致性模型的宋飏,年纪轻轻但是已被评为扩散模型圈OG(元老)了。

出自:https://mp.weixin.qq.com/s/My3A9dLxyT3wLnHLNgeSng