阿里通义实验室薄列峰:从兵马俑跳“科目三”到照片唱歌,四大框架让AI生成的人物活起来丨GenAICon 2024

四大框架玩转AI人物视频生成,已落地通义千问APP。

2024中国生成式AI大会于4月18-19日在北京举行,在大会首日的主会场开幕式上,阿里巴巴通义实验室XR团队负责人薄列峰博士以《人物视频生成新范式》为题发表演讲。

随着Sora等文生视频模型掀起热潮,很多人都在探讨文生视频模型能不能算作世界模型。对此,薄列峰认为,文生视频模型与世界模型的机制存在差异,视频是一个观察者角色,并不能真正改变世界,文字与物理世界描述之间也具有不对应关系。

人物视频生成模型是阿里通义实验室XR团队的一个研究重点。薄列峰通过人物动作、人物换装、人物替身、人物唱演4个框架来解读人物视频生成新范式。基于这些框架的应用,正逐步落地通义千问APP。

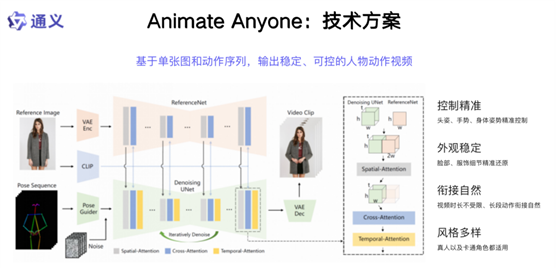

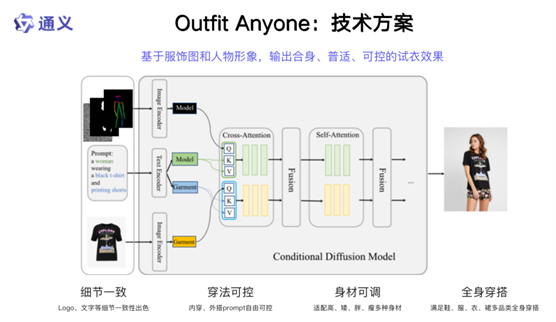

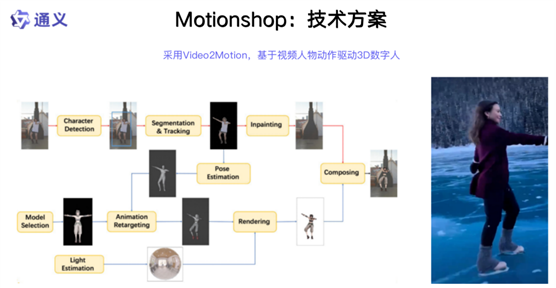

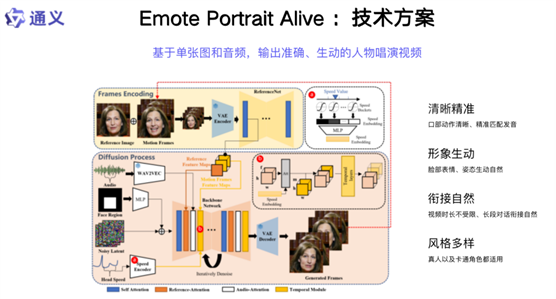

人物动作视频生成框架Animate Anyone可基于单张图和动作序列,输出稳定、可控的人物动作视频;人物换装视频生成框架Outfit Anyone是基于服饰图和人物形象;人物视频角色替换框架Motionshop采用Video2Motion,基于视频人物动作驱动3D数字人;人物唱演视频生成框架Emote

Portrait Alive能够基于单张图和音频,输出准确、生动的人物唱演视频。

以下为薄列峰的演讲实录:我的分享前半部分讲行业趋势以及我在多模态、文生文等方向的思考;后半部分分享我们在文生视频生成方向的工作。可以非常自信地说,我们在整个业界具备领先性,整个工作也有很强的特色。

01.文生视频模型基于统计关系,不是世界模型

首先,文生视频高速发展,大家讲发展基石的时候都会讲到数据、机器、人才。什么是多模态?什么是视频?文生视频这个领域基础又是什么?目前思考得还比较少。先回顾一下进程,大家可以看到Midjourney在文生图方向的突破;OpenAI借助非常强的理解大模型、能够对图像实现精标的能力,在文生图上做出自己有特色的工作和突破;创业公司像Pika、Runway也在做自己的工作,分别从不同的路径和方向来演进;包括谷歌、大的创业公司,过去一年有很多文生视频方向的研究工作。这些工作从研究的角度有一定数量的数据集,做一些方向的突破可能没有那么难。OpenAI相当于把这个事情做到了极致,在现在的时间节点,整个Sora展示出非常好的效果。文生视频是不是世界模型?它和世界模型的机制还是有所差异的。首先视频是一个观察者的角色,我们有一些摄像机在记录这个世界,但它不是真的去改变这个世界。如果说我需要做一些世界模型,类似我需要一些具身智能,当然这也是大家提出的一些新名词,具身智能是在仿照我们生物智能。生物智能不光有思考,同样也有实体,如果看实体的部分,具身智能现阶段还是远远落后的,因为人体具备非常强的灵活性和低碳的消耗,不是今天物理机器所具备的,这是一个差异点。另一点,如果看文生视频,视频的存在并不依赖于文字是否存在。文字出现以前,地球上的生物就可以看到这个物理世界。文字是我们引入去描述人自身的思想,随着人类进化了很多代,是我们引入的一个工具,实际可能跟今天的编程语言也是类似的。我们引入一个工具来描述这个物理世界,它具有相当的描述能力,但是它和物理世界之间也不对应,也就是说它有简化、有抽象、有归纳等。整个文生视频做的工作是什么?有一个视频空间,还有一个文字空间。我们在文字空间给每个视频打上标或者找到一个对应。整个关系是一个统计的依赖关系,通过这样的关系和暴力的关联,再加上大数据,展现出了一定的文生视频能力,但是不代表这是我们物理世界真实运作的规律。如果看文生文、文生视频,它们并不影响我们的物理世界,如果要影响物理世界,它还是需要达到生物智能所具备的特点。在这里也分享我对AGI的理解。通过文字我们是否能实现AGI?首先文字的能力于生物智能而言,不是完整的。非完整的AI智能是否达到人类智能所具备的能力?现在看还是有相当的距离。如果今天让大模型去造一辆汽车,造一台电视可以吗?以我的观点来看,还是比较遥远的。

02.做特色的人物视频生成,能换装唱演、角色富有表现力

通义实验室在视频生成方向有一些探索,我们也有完整的视频生成矩阵性的产品和研究。回到今天分享主题的核心——人物视频生成,当大家讨论这个问题的时候,第一个问题是,为什么不做一个通用的视频生成就完了,为什么还要做人物视频生成?视频生成和人物视频生成有共性,需要高质量的画质,包括整个运动要符合物理规律。如果看人的组成,包括人脸、人手、人的头发、人的服饰都具有相当的唯一性,同时展示出了非常精细的颗粒度。人物的特点、声音,这些还是人的感知部分,我们都还没有讲到人的实体部分,包括人是由物质组成的等,不同的部分是不同的物质,这些模拟可能是另一个层面,包括我们是否能制造出一种材料跟生物智能是类似的等等,这部分不是我们覆盖的主题。整体来看,它(人物视频生成)是相当有特色的,会导致在生成中有很多特性,包括控制是多样的,比如可以用声音来做控制,可以用人体的一些表达来做控制,可以用文本来做控制。控制具备丰富性,同时它生成的人的整体表现力需要非常丰富,如果生成的人表现力非常呆板,很难满足今天应用的需求。另外,生成的颗粒度、数字资产和人物运动的分离等,都是极具特色的部分。我们的工作包括人物动作、人物换装、人物替身、人物唱演等。接下来分享每个模块各自的工作。

03.人物动作视频生成框架Animate

Anyone:让兵马俑跳《科目三》

第一部分,我们在2023年11月发布人物动作视频生成框架Animate

Anyone,在人物视频生成方向的发布早于Sora几个月,当我们把这个结果发布出来之后,引发了非常强烈的关注,主要是达到的视觉效果超越了之前的结果,可以说是一个数量级的超越。

整个方案的框架有几个特色:第一,有一张参考图,整个生成过程会对参考图做高度的保真。大家如果在生成的时候看视频的细节,可能会发现,随着时间的推移,整个像素的物理合理性可能不太对。我们有机制,在融入的过程中,不光有CLIP的特征,还有视觉特征的融入,可以把更精确的信息编码进来,这是一个特点。第二个特点,我们用骨骼训练控制人物的动作。大家如果看整个人体的模拟,特别是整个人体的关节,每个关节点有它的自由度,整体上骨骼与人体也是非常匹配的表达。第三,引入时序模块,保证时序上的一致性。我们和Sora的效果对比,视频效果比Sora的方法有一个非常明显的提升。我们也把技术产品化,部署到通义APP,欢迎大家下载体验。我们的舞蹈生成获得了相当多的关注,整个视频内容播放达到了非常高的数字。画面中的舞蹈,包括真人、卡通形象(都可以)来跳《科目三》。当看产品演进的时候,我们发现一个非常有意思的事情,真人来跳舞这件事是我们自己可以去实现的能力,虽然对于每个人而言难度各有不同,舞蹈跳得比较好的能跳出比较好的《科目三》,舞蹈跳得不好也能跳出《科目三》的样子。但是对于一些其它类人的形象,比如兵马俑,我们不太可能去让它跳《科目三》。如果过去要让一个兵马俑跳《科目三》,我们要走的流程是什么?(以前)我们要做一个三维模型,人为设计它的动作,整个成本流程非常高。我们现在只要输入一张照片,兵马俑就可以跳《科目三》。画一幅画,给自己喜欢的宠物拍一张照片,输入喜欢的各种二次元形象,它都可以来跳创作者喜欢的舞蹈。Animate Anyone赋予创作者相当大的灵活度,特别在之前很难创作出这样动作视频的领域,给大家提供了一个工具。新的功能也在开发中,包括任意上传一段视频可以来提取骨骼序列,然后把骨骼序列传递的动作信息转移到这张照片上面,生成一段舞蹈。这会再次释放大家动作视频创作方面的潜力,甚至一些有难度的类人形象,我们能够通过手绘骨骼点,让它也跳起来舞蹈。我们把手绘的骨骼点和自身定义的骨骼点做一个匹配,来完成这样一个工作。Animate Anyone发布的时候,四个视频在(社交平台)Twitter上总播放量破亿,还有大量的自发报道。

04.人物换装视频生成框架Outfit

Anyone:一键为模特换装

第二部分,人物换装视频生成框架Outfit Anyone。在一个文明社会,每个人都有穿着服饰的需求,对美观度有极高的需求。我们打造了一个框架,可以给定一个服饰,然后让这个服饰穿到自己或者模特的身上,具备细节可控、身材可调、全身穿搭甚至多层服饰的叠穿等特征,面临非常细节问题的处理。

当我们真正要满足大家需求的时候,服饰的一致性非常重要,叠穿怎么和拍得高质量照片达到一样的画质、精度,相当有挑战。在一个模特换装应用中,将鼠标点击、上移、下移,点击试穿,就会让模特试穿衣服。我给定一些特别的材质,比如香蕉(图像)等,我们也能把它当衣服一样穿到身上来。整个模型在尝试把各种各样的布料或者类似布料的东西上身,为创意提供了一个路径。当然我们也可以把Outfit Anyone和Animate Anyone结合,去生成一段走秀视频等。相关作品获得了相当的关注,在Hugging Face上榜,关注度非常高。

05.人物视频角色替换框架Motionshop:生成3D模型动作视频

人物视频角色替换框架Motionshop,给定一个视频,提取它的骨骼,同时把骨骼和三维模型做绑定,生成三维模型的动作视频,然后还原在原视频中。这样的视频和Animate Anyone的区别是,3D资产(包括3D IP)也是相当大的领域,特别在游戏和影视,现在的Motionshop方案支持多视角的方案。

Motionshop支持多人替换,这样的视频替换成二次元的角色,后面的视频背景相当真实,前面的人物是虚拟人物,包括实际干活儿的视频。这里也产生了一些对机器人能力的思考。在整个方案中,要让整个视频看起来非常真实,除了大模型的能力,我们还运用了渲染的能力,包括光线追踪,会从原视频估计光照等,这样让整个视频看起来非常一致,没有违和感。把机器人带到对话场景中,也是非常有意思的一个应用。整个置换会在场景中有非常好的体现,超越了目前一些类似的方法所能做到的能力。

06.人物唱演视频生成框架Emote

Portrait Alive:让照片开口唱歌

年后我们沿着对人物视频生成独立的思考,不断地向前探索,最新的工作是人物唱演视频生成框架Emote Portrait Alive。给定一张照片,可以让这个人来唱歌、讲话(这项功能已于近期上线通义APP)。当然了,四五年前大家都在研发这样的能力,对于人物视频生成而言,表现力是极度重要的,如果今天达到一个类人的表现力,在我来看是很难实现的。

我们要达到专业级,这才是真正大家使用的内容生成。很多生成的视频画质是OK的,但是大家有没有思考这样的问题,比如说文生图、生成的视频,你是这个视频的消费者吗?你会看吗?当然模型可能会生成这个世界上不存在的物种,这是很有意思的,但你会长期去消费这样的内容吗?我觉得在做AIGC内容生成之前,不管是基础研究还是应用思考,大家都在高速迭代,每个人都有自己的思考和对这个问题的答案。在我们生成的过程中,基于这样一个包括动作、唱歌(嘴型)、声音表演的生成,我们可以去打造一个非常有吸引力的甚至可以去做演艺的形象,甚至可以做一个虚拟的明星。

出自:https://mp.weixin.qq.com/s/DqXDxlSEajCxopjF7wAWnA