阿里巴巴发布了Marco-o1!

阿里巴巴刚刚发布了一款全新的开源推理模型Marco-o1,它不仅专注于标准答案领域,更致力于解决开放性问题。

这个名为Marco-o1的模型可不是简单的大语言模型。

它通过思维链(CoT)微调、蒙特卡罗树搜索(MCTS)和反思机制等创新技术,让AI在处理复杂问题时更加得心应手。

为什么Marco-o1如此与众不同?

它不再局限于数学、物理和编程等有标准答案的领域,而是勇敢地迈向了没有标准答案的开放性问题。这就像是让AI从「做选择题」进化到了「写论文」的水平!

技术亮点全解析

Marco-o1的核心优势体现在四个方面:

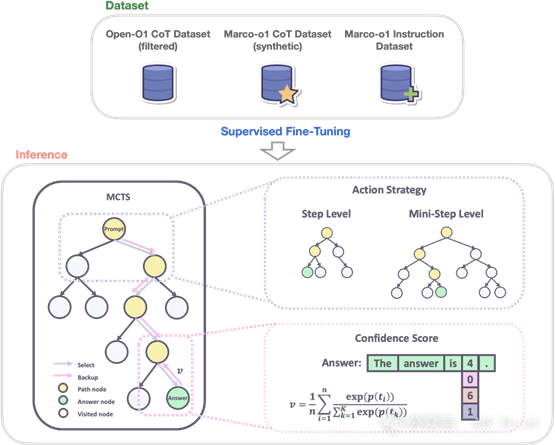

思维链微调:团队使用开源CoT数据集和自研合成数据对基础模型进行全参数微调,打造出Marco-o1-CoT。

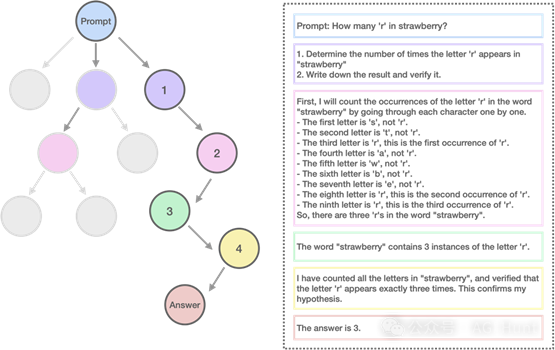

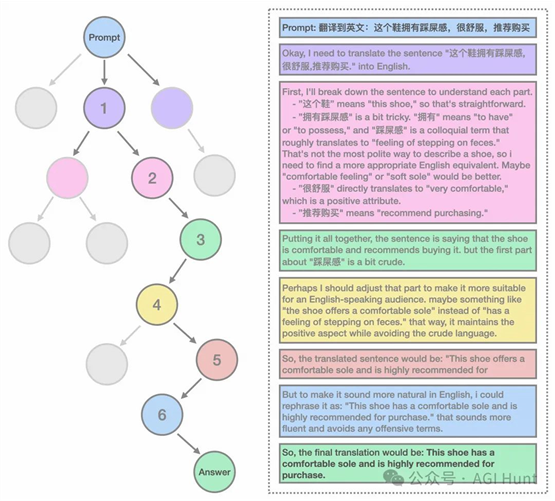

MCTS解决方案扩展:通过将大语言模型与蒙特卡罗树搜索(MCTS)相结合,利用模型输出的置信度来指导搜索,大大扩展了解决方案空间。

创新推理策略:实现了全新的推理行动策略和反思机制(Marco-o1-MCTS Mini-Step),在MCTS框架内探索不同的行动粒度,并引导模型进行自我反思。

突破性翻译应用:首次将大型推理模型(LRM)应用于机器翻译任务,探索多语言和翻译领域的推理时间扩展规律。

实力有多强?数据说话!

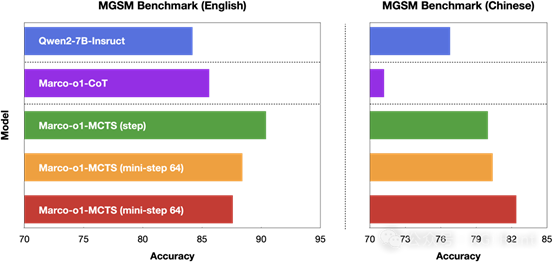

研究团队在Qwen2-7B-Instruct的基础上,通过精心设计的数据集进行微调。实验结果显示:

·

MGSM英文数据集:准确率提升6.17%

·

MGSM中文数据集:准确率提升5.60%

最让人惊喜的是,Marco-o1在翻译任务上展现出了惊人的实力。它能够准确理解并翻译俚语表达,将「这个鞋拥有踩屎感」这样的口语化表达优雅地转化为「This shoe has a comfortable sole」。

开箱即用!快速上手指南

想要体验Marco-o1的强大功能?只需要几行代码:

# 直接加载模型

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("AIDC-AI/Marco-o1")

model = AutoModelForCausalLM.from_pretrained("AIDC-AI/Marco-o1")

如果你想使用vLLM加速推理,可以直接运行:

./src/talk_with_model_vllm.py

这个来自阿里巴巴国际数字商业部MarcoPolo团队的新作品,正在为AI的推理能力开辟新天地。它不仅能解决标准问题,更重要的是能够处理那些没有标准答案、难以量化的开放性问题。

这或许就是AI走向真正智能的关键一步。毕竟,人类面对的大多数问题,都不会有标准答案。

Marco-o1的开源,将为整个AI社区带来新的可能。

相关链接

[1] https://huggingface.co/papers/2411.14405

[2] https://huggingface.co/AIDC-AI/Marco-o1

原文出自:

https://mp.weixin.qq.com/s/taWAZsK_ITJYKM3q_Ssqwg