艺术家对AI侵权的反击来了——

在画作里“投毒”,AI用了就会“中毒”出故障。

投毒工具由芝加哥大学团队打造,名为Nightshade,可以对画中像素添加隐形更改。

被下毒的画一旦被非法抓取成为训练数据被AI吃掉,模型就会生成混乱。

甚至还可能会破坏DALL-E、Midjourney、Stable Diffusion……这些绘图模型的正常迭代。

艺术家对AI侵权的反击来了——

在画作里“投毒”,AI用了就会“中毒”出故障。

投毒工具由芝加哥大学团队打造,名为Nightshade,可以对画中像素添加隐形更改。

被下毒的画一旦被非法抓取成为训练数据被AI吃掉,模型就会生成混乱。

甚至还可能会破坏DALL-E、Midjourney、Stable Diffusion……这些绘图模型的正常迭代。

先来看一波模型中毒发作时的样子。

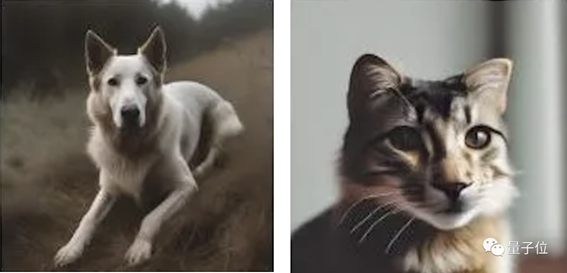

没中毒时模型生成的狗是左图这样婶儿的,中毒后生成的狗如右图(喵):

生成汽车更离谱,这是生成了辆牛车?

此外,研究人员用Stable Diffusion测试毒效,只需50张毒图,就能让模型输出变得奇怪;数量达到300张时,生成的图像已经完全变成了另一个物种。

△生成手提包和帽子,从左到右:没被下毒、用50张有毒图训练、100张、300张,下同

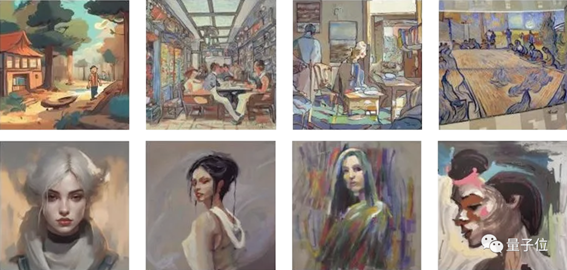

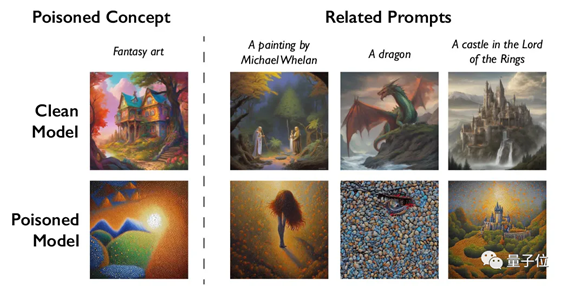

看过了实物生成,再来看生成不同艺术风格的画。

模型中毒后把奇幻艺术生成了点彩画法,立体主义生成了动漫风格:

卡通、概念艺术等也没能逃过:

重点是,由于模型训练数据量庞大,模型中毒后,AI模型开发者想清理有毒的数据样本也很难。

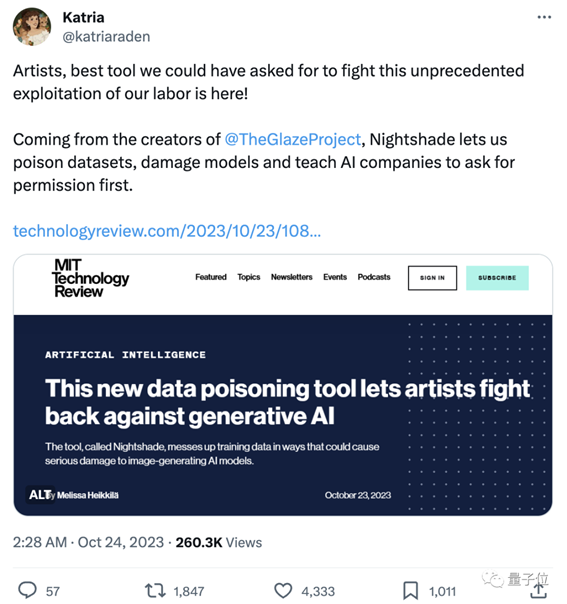

这款工具一经曝出,艺术创作者们就赶紧转发了起来,热度一路飙升。

路过的艺术创作者纷纷拍手叫绝:

终于有可以用来反击的东西了💪

看热闹的网友也不少,开始调侃此前一些AI公司“适者生存”、“不能阻止技术进步”的回应:

AI兄弟们:适者生存,不然就die。

艺术家:好吧,制造毒液。

AI兄弟们:等等,不是这个意思啊!

不少网友将其称为“艺术的反击”:

很高兴看到关于创意DNA拉锯战正在展开。

双管齐下&毒性很强

研究团队不止开发了一款工具,还有一个工具叫做Glaze,可以“掩盖”艺术家的个人风格。

它的原理和Nightshade类似,也是对图像像素做一些微妙地改变,肉眼根本看不出来,但却可以操纵模型将图像解释成与实际内容不同的东西。

研究团队还打算把Nightshade集成到Glaze中,艺术家可以自己选择是否要下毒。

领导开发团队的芝加哥大学教授Ben Zhao表示:

希望此举能够让作品权利从AI公司回归到艺术家,通过形成有力的威慑,保护艺术家的版权和知识产权。

团队在用Stable Diffusion的最新模型以及从头训练的基础模型测试毒效时还发现:

“生成式AI模型擅长在词与词之间建立联系”这一特点有助于毒素的传播。

比如说,Nightshade不仅会影响“狗”的生成,还会影响“小狗”、“哈士奇”、“狼”等所有类似的概念。

有间接联系的概念也同样会受影响,标为“奇幻艺术”的有毒图像,也会影响“龙”、“《指环王》中的城堡”等的生成。

Ben Zhao教授虽承认这种工具有可能会被恶意使用,但表示:

攻击者想对那些经过数十亿数据训练的大模型造成实质性的伤害,将需要数千个有毒的样本。

据MIT Technology Review消息,Nightshade的研究已向网络安全顶会Usenix提交同行评审。

同时Nightshade也是奔着开源去的,其他人之后也可以修改制作不同的版本。

引起圈内外热议

这个工具不仅引起了艺术家和网友们的讨论,一些专家学者也纷纷提出了自己的看法。

专注于研究AI模型安全性的康奈尔大学教授Vitaly Shmatikov就说:

我们目前还不知道如何有效地防御(模型抓取数据),也还没有在现实中看到针对机器学习模型的下毒攻击,但这可能只是时间问题,现在就应该开始研究防御手段。

研究AI模型数据隐私和鲁棒性的滑铁卢大学助理教授Gautam Kamath表示:

太棒了。研究显示,这些新模型的漏洞并不会神奇地消失,实际上问题只会变得更加严重。尤其是随着时间的推移,这些模型变得更加强大,人们对它们的信任度增加时,所面临的风险也只会增加。

使用过Glaze的插画师Eva Toorenent还透露:

Stability AI、OpenAI等开发生成式绘图模型的AI公司已经提议,让艺术家选择不用他们的画来训练之后版本的模型。但艺术家们表示这还不够,因为选择退出流程需要进行一系列复杂操作,而技术公司仍然握有所有的权力。

这会让AI公司三思而后行,如果未经我们的同意就取用我们的作品,他们很可能会毁掉自己的整个模型。

出自:https://mp.weixin.qq.com/s/nFFqBaS6fICwLz8xeKfhVw

本文档由网友提供,仅限参考学习,如有不妥或产生版权问题,请联系我们及时删除。

客服请加微信:skillupvip