本文综述了基础模型在机器人学中的应用,包括感知、决策与规划、控制等方面。视觉Transformer和视觉-语言模型提高了机器人感知的通用性和泛化能力,大型语言模型助力决策与规划,实现了从语言到行动的映射,而扩散模型和视觉-语言模型则优化了机器人控制。基础模型为机器人注入了语言理解、视觉泛化、常识推理等能力,预示着机器人学的新发展。未来,基础模型在机器人领域的应用将更广泛,需解决实时性、鲁棒性和可解释性等问题,推动机器人技术为社会带来更大福祉。

基础模型(Foundation Models)是近年来人工智能领域的重要突破,在自然语言处理和计算机视觉等领域取得了显著成果。将基础模型引入机器人学,有望从感知、决策和控制等方面提升机器人系统的性能,推动机器人学的发展。由斯坦福大学、普林斯顿大学等多所顶尖学府,以及英伟达、Google DeepMind等众多知名企业组成的联合研究团队,发布了一篇综述报告。该报告全面梳理了基础模型在机器人学各个领域的应用现状,分析了其优势和局限性,并展望未来的研究方向。

基础模型通过在大规模数据上进行预训练,学习到了丰富的语义信息和世界知识。与传统的特定任务模型不同,基础模型具有较强的通用性和迁移能力,能够应用于多种不同的下游任务。一方面,基础模型能够作为机器人系统的先验知识,减少对任务特定数据的依赖;另一方面,基础模型可以作为机器人系统的通用组件,实现感知、推理和规划等核心功能。

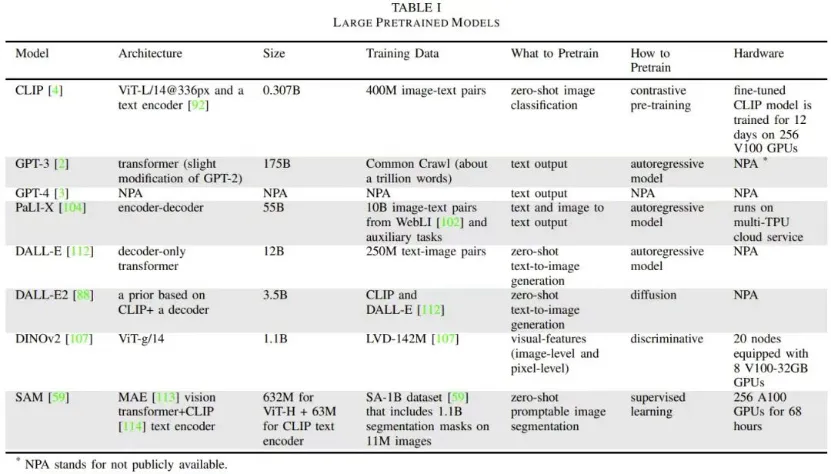

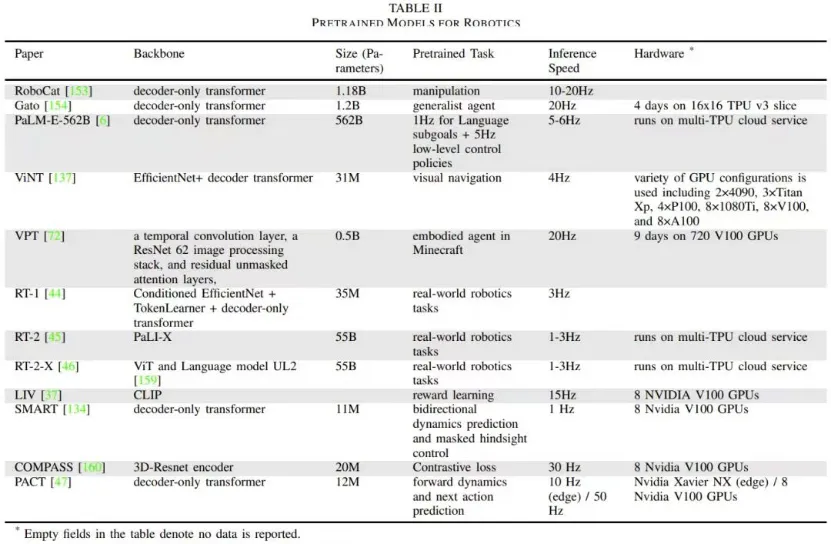

基础模型主要包括以下几类:

1、大型语言模型(Large

Language Models):如BERT、GPT-3、PaLM等,主要应用于自然语言处理任务。

2、视觉Transformer模型:如ViT、Swin Transformer等,主要应用于计算机视觉任务。

3、视觉-语言模型(Vision-Language Models):如CLIP、ALIGN等,通过跨模态对比学习实现视觉与语言的对齐。

4、具身多模态语言模型(Embodied

Multimodal Language Models):如R3M,将视觉、语言与机器人动作相结合进行学习。

5、视觉生成模型(Visual

Generative Models):如扩散模型和GAN等,用于视觉信号的生成。

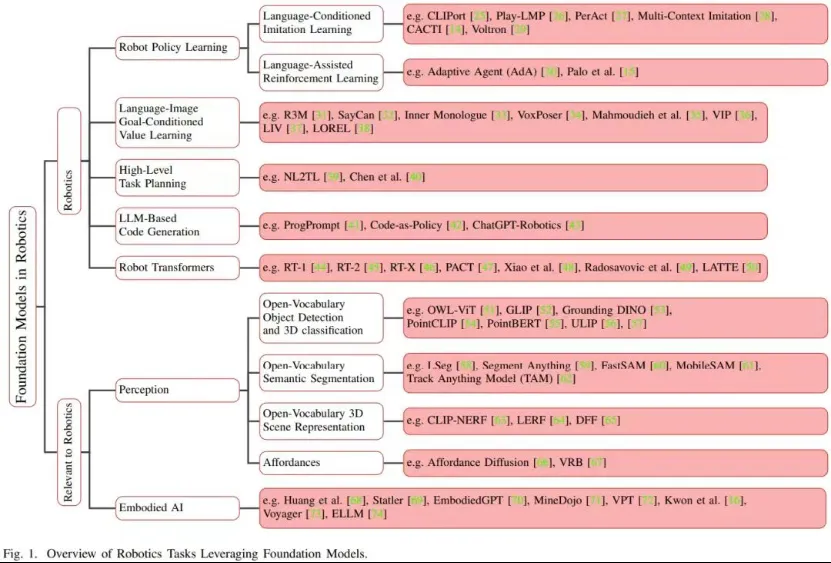

本文将重点分析基础模型在机器人学各个领域的应用,并讨论相关技术挑战和未来机遇。介绍基础模型在机器人感知中的应用、基础模型在机器人决策与规划中的应用、基础模型在机器人控制中的应用,总结全文并展望未来。

机器人感知中的基础模型应用

感知是机器人系统的重要组成部分,旨在从原始传感器数据中提取语义信息,以支持决策和控制。传统的机器人感知方法依赖于特定场景下的特征工程和模型设计,难以适应开放环境的复杂性和多样性。近年来,深度学习的发展使得从大规模数据中端到端地学习感知模型成为可能。基础模型进一步扩展了这一范式,使得机器人系统能够利用更广泛的先验知识,实现更强大、更通用的感知能力。

在视觉感知方面,视觉Transformer模型展现出了强大的特征提取和泛化能力。以ViT为代表的纯Transformer模型直接将图像分割为序列,通过自注意力机制学习像素间的全局依赖,在ImageNet等大规模数据集上取得了超越CNN的性能。进一步地,Swin Transformer等层次化的Transformer模型能够更好地建模视觉信号的多尺度特性,在检测、分割等下游任务上取得了显著的性能提升。在机器人领域,视觉Transformer模型可以用于构建更鲁棒、更通用的视觉感知模块。以OWL-ViT为例,该模型将ViT与开放词汇对象检测相结合,能够识别数百种未在训练集中出现的物体类别,为机器人系统提供了更广泛的物体理解能力。

在语义感知方面,视觉-语言模型为实现开放词汇的识别和理解提供了新的思路。以CLIP为代表的对比语言-图像预训练模型通过最大化图像特征与文本特征的互信息,学习了视觉与语言的对齐映射。在下游任务中,CLIP可以根据文本描述动态生成视觉分类器,实现开放集识别。进一步地,CLIP可以作为视觉骨干网络,用于引导其他感知任务的学习,如分割、检测等。以CLIP-SAM为例,该模型采用CLIP作为视觉编码器,引入文本描述构建语义分割模型,能够泛化到新的物体类别和场景。在机器人领域,CLIP等视觉-语言模型为实现开放词汇的物体识别、关系理解等提供了重要基础。

在交互感知方面,具身多模态语言模型为机器人学习复杂的操作行为提供了新的范式。以R3M为例,该模型在视觉、语言和机器人动作数据上进行预训练,通过掩码自回归学习视觉-语言-动作的表示。在下游任务中, R3M可以根据语言指令和视觉观察生成对应的机器人动作,实现跨模态的指令跟随和技能学习。相比于传统的模仿学习方法,R3M引入了语言模态,使得机器人能够理解更抽象、更多样的指令,具备更强的泛化能力。未来,如何进一步提高具身语言模型在开放环境中的鲁棒性和安全性,是亟需解决的问题。

总的来说,基础模型为机器人感知提供了先验知识和泛化能力。在视觉感知方面,视觉Transformer模型实现了更鲁棒、更通用的特征提取;在语义感知方面,视觉-语言模型实现了开放词汇的识别和理解;在交互感知方面,具身语言模型实现了跨模态的指令跟随和技能学习。未来,如何进一步提高基础模型在机器人感知任务中的性能和效率,如何利用多模态信息实现更高层次的场景理解,都是亟需探索的方向。

机器人决策与规划中的基础模型应用

决策与规划是机器人系统的核心功能,旨在根据感知信息和任务目标,自主地选择行动策略并生成动作序列。传统的机器人决策与规划方法依赖于精确的环境模型和专家知识,难以适应非结构化环境的不确定性和复杂性。近年来,深度强化学习的发展使得机器人能够从数据中学习决策与规划策略,但其样本效率和泛化能力仍有待提高。基础模型为机器人决策与规划引入了丰富的先验知识,有望进一步促进该领域的发展。

在任务规划方面,大型语言模型展现出了将自然语言指令转化为可执行计划的能力。以PaLM-SayCan为例,该模型首先在大规模语料上训练一个通用的语言模型,然后在机器人指令数据上进行微调,学习将高层指令映射到低层动作的策略。在测试阶段,PaLM-SayCan可以根据用户提供的自然语言指令,生成相应的机器人动作序列,并交由运动规划模块执行。实验表明,PaLM-SayCan能够处理复杂的日常操作指令,大大提高了机器人的语言理解和任务泛化能力。类似地,SayCan等模型也展示了将语言指令转化为视觉操作序列的能力。

在运动规划方面,扩散模型为生成平滑、多样的机器人轨迹提供了新的思路。以DiffSkill为例,该模型通过学习轨迹数据的条件分布,实现了从起始状态、目标状态和语言指令到轨迹序列的映射。在规划阶段,DiffSkill根据任务要求,通过反向扩散过程生成平滑、自然的机器人轨迹,并交由运动控制模块执行。相比于传统的轨迹优化方法,DiffSkill能够同时兼顾轨迹的平滑性、多样性和语义一致性,为机器人运动规划提供了更灵活、更高效的解决方案。

在策略学习方面,基础模型为提高强化学习的样本效率和泛化能力提供了新的思路。以VIMA为例,该模型利用CLIP将视觉观察映射到语言空间,得到紧凑且语义丰富的状态表示。在此基础上,VIMA通过对比学习建立起状态表示与最优动作之间的映射,实现了跨任务、跨环境的策略泛化。实验表明,VIMA在视觉导航、机械臂操作等任务中显著减少了所需的交互样本数量,展现出了强大的知识迁移能力。类似地,CLIP-TD3、CLIPort等模型也展示了利用视觉-语言模型来引导策略学习的有效性。

总的来说,基础模型为机器人决策与规划引入了语言理解、常识推理等关键能力。在任务规划方面,大型语言模型实现了将自然语言指令转化为可执行计划;在运动规划方面,扩散模型实现了平滑、多样轨迹的生成;在策略学习方面,视觉-语言模型实现了高效、泛化的策略学习。尽管取得了可喜的进展,但如何进一步提高基础模型在机器人决策与规划中的可解释性、安全性和实时性仍是亟需探索的问题。此外,如何将决策与规划与感知、控制更紧密地结合,构建端到端的自主系统,也是未来的重要研究方向。

机器人控制中的基础模型应用

控制是机器人系统的执行部分,旨在根据感知信息和决策指令,精准、稳定地控制机器人执行器完成预定动作。传统的机器人控制方法依赖于精确的动力学模型和专家知识,难以适应非结构化环境的不确定性和复杂性。近年来,学习型控制的发展使得机器人能够从数据中学习控制策略,但其泛化能力和鲁棒性仍有待提高。基础模型为机器人控制引入了丰富的先验知识和泛化能力,有望进一步突破传统控制方法的局限性。

在轨迹跟踪控制方面,扩散模型展现出了从语言指令生成平滑、准确机器人轨迹的能力。以 DiffTraj 为例,该模型通过学习轨迹数据的条件分布,实现了从起始状态、目标状态和语言指令到轨迹序列的映射。在控制阶段,DiffTraj根据高层指令,通过反向扩散过程生成平滑、准确的机器人关节轨迹,并交由底层控制器执行。实验表明,DiffTraj能够根据简单的语言描述生成复杂的操作轨迹,如"打开抽屉"、"倒水"等,大大提高了机器人控制的灵活性和易用性。

在模仿学习方面,视觉-语言模型为机器人学习复杂技能提供了新的范式。以CLIP-ASAP为例,该模型首先利用CLIP将视频帧编码为语义特征,然后通过因果语言建模学习动作与视觉变化之间的关系。在控制阶段,CLIP-ASAP根据语言指令和当前视觉观察,预测下一时刻的关键帧,并将其传递给低层控制器执行。实验表明,CLIP-ASAP能够学习复杂的长期技能,如烹饪、家政等,且具有很强的泛化能力,能够根据不同的指令组合技能。类似地,R3M、Pix2R等模型也展示了利用视觉-语言对齐进行模仿学习的能力。

在强化学习领域,基础模型为引入先验知识和提高样本效率提供了新的思路。以LanguagePlan为例,该模型利用GPT-3根据任务描述生成抽象的行动计划,如"先走到门口,然后打开门,再走出房间"。然后,LanguagePlan将该行动计划嵌入到状态空间中,作为额外的观察信息,用于训练一个分层强化学习智能体。实验表明,LanguagePlan能够显著提高样本效率和泛化性能,加速复杂任务的学习。类似地,LOFT、T-EBM等模型也展示了利用语言模型引导策略学习的能力。

尽管基础模型在机器人控制中展现出了广阔的应用前景,但如何进一步提高其实时性、鲁棒性和可解释性仍然是亟待解决的问题。此外,如何将控制与感知、决策和规划更紧密地结合,构建端到端的自主系统,也是未来的重要研究方向。

总结与展望

本文全面梳理了基础模型在机器人学各个领域的应用现状。在机器人感知方面,视觉Transformer和视觉-语言模型实现了开放词汇的物体识别、语义分割和交互感知;在机器人决策与规划方面,大型语言模型展示了从自然语言指令生成行动计划和策略的能力;在机器人控制方面,扩散模型和视觉-语言模型实现了从语言指令生成平滑轨迹和模仿复杂技能的能力。这些应用表明,基础模型为机器人系统注入了语言理解、视觉泛化、常识推理等关键能力,有望推动机器人学的新一轮发展。

展望未来,基础模型驱动的机器人学必将迎来蓬勃发展,并有望实现机器人系统的新一轮突破。同时,它也为机器人学和人工智能的基础理论研究提供了新的视角和方法。未来,机器人学和人工智能领域的研究者需要携手合作,进一步挖掘基础模型的潜力,并解决其落地部署所面临的挑战,推动服务机器人、工业机器人和特种机器人等领域的发展,造福人类社会。

本文档由网友提供,仅限参考学习,如有不妥或产生版权问题,请联系我们及时删除。

客服请加微信:skillupvip