翻看了上古时期出的图,突然老脸一红,有点惭愧。原来最开始sd画小姐姐脸崩得我有些不知所措了。比如这样,这样,还有这样。(人物画面越小越崩溃)

好在webui后来有了真正的面部修复After Detailer的出现。(还有就是webui自带的hiresfix旁的面部修复,那个勾选千万不要用,千万不要用,千万不要用。那不是面部修复,那是邪神开关。

不知道AD是个啥的看这:【Stable Diffusion】脸部修复插件After

Detailer

所以可以说好的人像作品全靠放大和修脸救!~

可是我们现在不是灭门换comfy了吗?comfy的放大我们已经安排过了(不知道的可以翻一下历史,不给门了)那comfy是否也有ad?ad的修复原理又是什么呢?今天我们浅浅熟悉了解一下。

还是老样子,AB航线提供选择。

1.🤔A航线 有webui的底子,想了解生图过程,能举一反三,进阶学习的。

2.🤓B航线 喂饭都不想吃,我只想无脑使用,出图效果好的。

如果跟随《Stable

Diffusion 防災指南》一路学习过来的朋友可以选择A航线继续跟随卡爷的节奏进入ComfyUI新世界,而对ComfyUI本身兴趣不大,但对比WebUI还简单无脑的生图很需要,直接跳过下面A部分,滑到后面的B航线就行,按需食用即可。

▍面部修复DDetailer(A航线🤔)

comfy生态里其实有很多面部修复的插件,只是他们可能不在叫AD了,从管理器里搜索安装节点,亦或是从a1111替换节点中检索,会找到很多个包含DDetailer的插件,这个就是comfy里的面部修复工具了。其实如果不是很需要了解其工作原理的话,无脑走B航线,整个复制进入你的工作流,用就完事了,管他怎么连的呢。

ComfyUI-Impact-Pack

以Impact插件为例吧,毕竟我们之前介绍插件的时候也花了一点篇幅介绍了一下这个全能强大的插件。不过大部分时候我们也主要只用到了ta的DD功能。

至于怎么安装这个插件,传送门:ComfyUI进阶前必备插件们续 >>>>

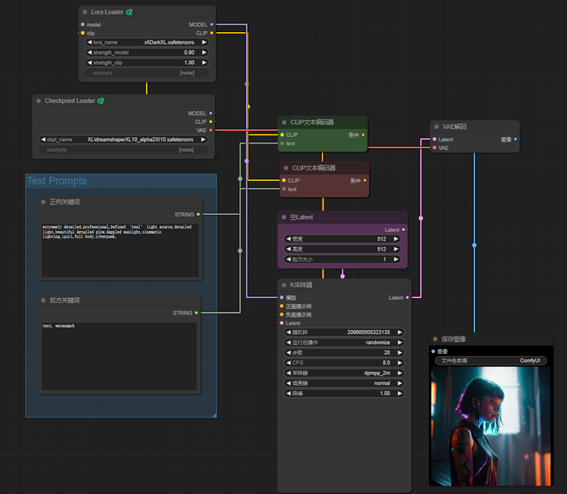

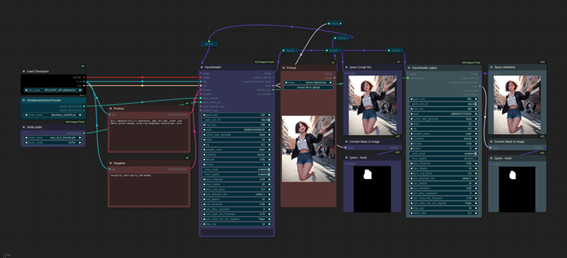

所以我们还是手动连接一遍。先把常规的生图连接好。如果是图生图就把latent输入改一下就行,如果只准备对已有的图片进行面部修复,去掉采样器直接图片进入就行(后面会有图片演示)

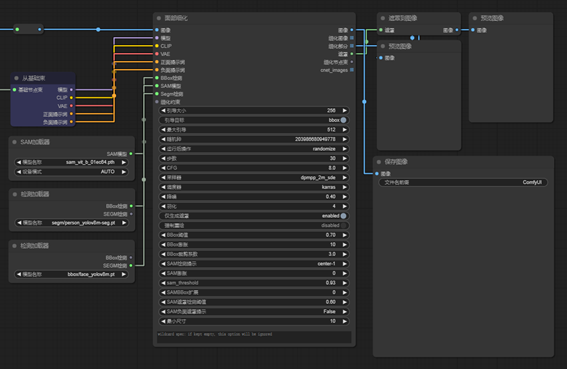

注意:DD针对图片进行输入,也就是所有生成输出的图片都可以接入DD,这与webui的AD的生成流程不一样,AD需要在生成中,而DD可以在生成后。来看一张官方演示workflow。

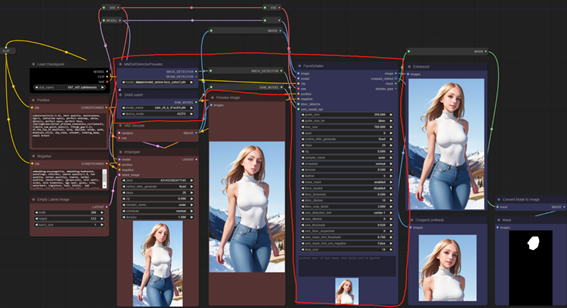

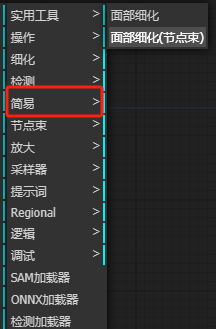

红色框内就是接在普通生成后的DD修复。主要包含3个节点块组成。

§

面部修复Detailer:你可以简单理解为一次采样器再生成。ta需要基础束进行输入(模型,关键词,clip,vae)以及下面2个节点。

§

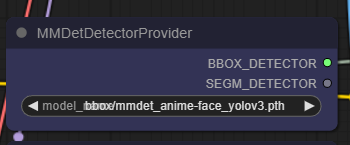

§ BBox—detector:检测加载器。用来加载可以识别面部,身体和手部(目前主要模型就是这三个)

§ SAMLoader:SAM模型加载器。这个模型是老朋友了,所有带Seg的插件都需要用SAM模型进行分离。

以上三个节点组合成了基本的面部修复功能。剩下的就是预览和存图了。比如我们将蒙版遮罩牵一条线出来,用来检查面部识别是否起作用&是不是识别对了。

需要注意的是检测加载器,官方使用了MMDet,而这个节点需要你到插件文件夹下手动安装的,比较麻烦,并且加载的模型是yolov3,也不知道和v8有什么不一样。我更推荐直接使用Impact自带的检测加载器替换这个节点。如果你导入发现红了,缺失了。就使用下面的这个替换吧。(重装了电脑后,我的MMDet也没了,算了也懒得弄了,本来应该出现在ONNX加载器上方的)

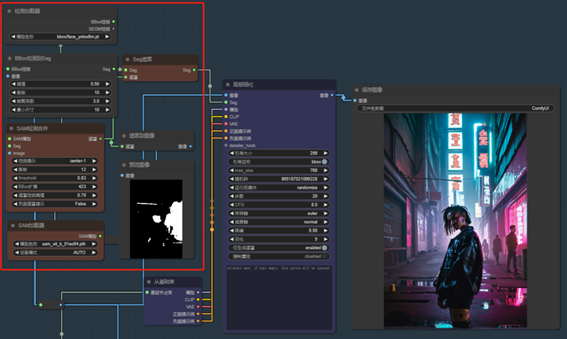

面部修复串联

如果你已经顺利连接好,也跑通了一遍后,那顺着官方文档的下一个部分,使用多个面部修复,反复摩擦一些“硬茬”!叫你屁股和脸长反了也能给你修好。

操作也很简单,面部细化节点输出端有一个节点束的输出。(你可以理解束这个东西就是一捆线,一个理线器。主要为了方便你走线)

然后再创建一个带有节点束的面部细化的节点,把两端一连就串联完毕啦。只要你乐意,可以串联七个八个,脸和手一起修都没问题。

另一种面部修复方法

Face

Bbox(bounding box) + Person silhouette segmentation (prevent distortion of the

background.)

就是将脸部识别配合人物轮廓分离,用来保证背景不会产生畸变。(我自己实际感受还可以,尤其是衣物的变化)

主要原理是使用Impact插件里的局部细化节点代替上面的面部细化节点。将面部识别的工作分拆出去,仍然使用face-yolo来识别面部,并给到分离出来带有遮罩的seg(绿色点点)

当然两种方法效果不一样,但孰好孰坏我没有明确答案,至少前者可以串联,我主要懒,用后者用的多,工作流导入也更习惯了。

需要注意的是细化的一些参数,重点提及一下强制重绘,如果很多时候发现面部识别不好,可以把这个开启一下,会有奇效。

最后再结合上一篇讲的放大,完成3个部分串联。这样你comfy出来的人像,肯定没问题啦!这大概就是很多人出小姐姐的workflow完全体了~

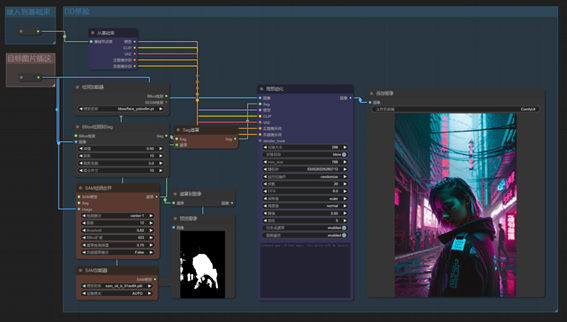

▍高清放大(B航线🤔)

导入工作流or图片

我已经把工作量都拆解成接线盒,你可以选择单独接还是无脑直接用,就随意了!

图片或者workflow的json文件,取走任意一种导入就能使用啦,B航线简直不要太简单!~

出自:https://mp.weixin.qq.com/s/FJx-Ma_Mkc0Kd-Hqb9g0ng