斯坦福的一组开发人员最近在推动自然语言处理的疆界,他们推出了一个叫做Lamini的新工具,它的目标是让每个开发者都能利用GPT-3和ChatGPT的强大能力。

LLM(大规模语言模型)的微调不再困难!!

我们都知道,大模型在某些特定的垂直场景,效果不是那么好,很多企业/个人都需要微调参数才可以让其在特定领域发挥出更好的作用。

而这个过程复杂且繁琐。

斯坦福的一组开发人员最近在推动自然语言处理的疆界,他们推出了一个叫做Lamini的新工具,它的目标是让每个开发者都能利用GPT-3和ChatGPT的强大能力。事实上,Lamini已经使得LLM(大规模语言模型)的微调变得简单,只需要10分钟和几行代码,你就能够微调你自己的模型。并且,Lamini提供的这项服务是完全免费的,只要你的模型参数在4亿以内。

项目地址:https://github.com/lamini-ai/lamini

它的优势如下:

· 免费,适用于小型 LLM;

· 迅速,10-15 分钟;

· 很大,无限大小的 prompt,比最大的 prompt 多 1000 倍以上的空间;

· 学习,检索增强生成,它不仅是在已知的基础上试图理解内容,还在学习新东西。

并且,在 Lamini 的项目地址中有着

· 1400 个问答数据集(这是关于 Lamini 的内部工程文档,你也可以将其自定义);

· 在此数据集上运行 LLM 微调的代码;

· 回答问题的开源微调 LLM(例如关于 Lamini,或其他你想问的)。

它允许无限大小的提示,这是传统的模型所不能比拟的。并且,Lamini使用了检索增强生成的方式,这让模型不仅能够理解已有的内容,还能够学习新的信息。Lamini的项目地址上还有一套包含1400个问题和答案的数据集,这些都是关于Lamini自身的,你也可以根据需要对它进行自定义。

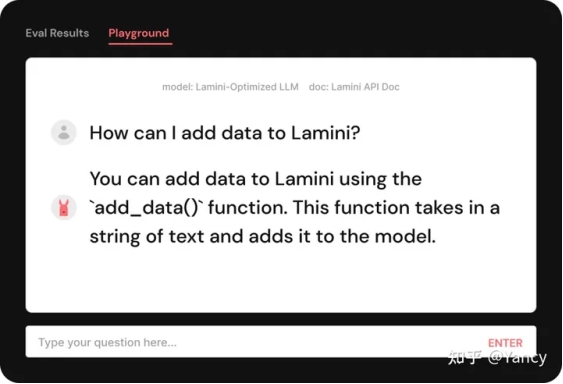

让我们通过一个例子来了解一下Lamini的使用方法。在这个例子中,我们有一个需要微调的模型,它是一个关于Lamini内部工程文档的问答式模型。这个模型是基于一个拥有410M参数的Pythia模型创建的。当我们向模型提问关于如何向Lamini添加数据的问题时,它给出的答案并不是我们想要的。

然后,我们将一个包含了1400个问题和答案的数据集输入到模型中,并让模型进行学习。

这个数据集虽然看起来不大,但它实际上比当前最大的提示要大得多。之后,我们只需要用几行代码就可以开始训练模型了。在大约10-15分钟之后,我们就可以使用这个新的微调过的模型了。

当我们再次向它提问相同的问题时,它给出的答案就完全正确了。

为了成功使用Lamini进行LLM训练,你需要首先定义LLM接口,然后获取相关数据并创建对应的Lamini类型。接下来,你可以将这些数据和类型加载到LLM中。最后,你可以通过优化训练来使模型更适合你的需求。只需要几步,你就可以轻松地训练你自己的大规模语言模型了。

以上就是Lamini的强大之处,它可以让微调变得更简单、更快速,而且完全免费。如果你也想尝试一下Lamini,可以访问他们的项目地址:https://github.com/lamini-ai/lamini进行查看。

Lamini官方网址: https://www.lamini.ai/blog

利用Lamini,每个人都可以掌握大规模语言模型的超能力。

出自:https://zhuanlan.zhihu.com/p/644125777

本文档由网友提供,仅限参考学习,如有不妥或产生版权问题,请联系我们及时删除。

客服请加微信:skillupvip