本文介绍了moe模型的开发背景及优势,特别强调了新发布的Qwen1.5-MoE-A2.7B模型的能力超过7B,具有推理速度快、部署成本低的特点。文章还通过一系列问题测试了该模型的能力,并详细描述了如何在本地部署该模型,包括所需算力、环境配置、模型下载等步骤。最后,文章提到模型权重和推理仓库的下载方式,但仅限特定会员专享。

现在整个hi ~

真是快!上年9月份,我们就在谈moe模型的开发,而且要小而精!

Mixtral等大部分优秀的模型,都用moe架构!

不得了!

刚刚!qwen发布了Qwen1.5-MoE-A2.7B模型!

这家伙2.7B!能力超7B!

短小精悍!

意味着推理速度快!部署成本低!

后面教育组AI落地,会考虑用它做实践!

当然啦!后面,也会单独教大家!如何做自己的moe专家模型!

【宣发】教育领域大模型+RAG系统实践项目!手把手+带你做真实项目!

能力如何?看到官方说,能力超过了DeepSeekMoE 16B!

当然!它说的不算,雄哥跑一跑,看看能力怎么样!

人的专注力只有10分钟!那,开干!

① 能力如何?

② 需要多少算力?如何部署?

③ 模型下载到本地

只想看如何部署,直接到第二部分!

第一部分:能力如何?

雄哥准备了几个问题,分别测试他的知识储备、逻辑推理、文本理解、多步骤计算能力、创造性能力,共5个方面!

1.1 知识储备

问:法国的首都在哪里?

答:法国的首都是巴黎。

这是第一个问题!还算干脆!但雄哥是GPU+CPU推理的,有点慢啊!

1.2 逻辑推理能力

问:如果小明比小红高,小红比小刚高,那么小明和小刚之间谁更高?请用逻辑推理证明您的答案。

答:根据题目中的信息,我们可以得出以下关系:小明 > 小红,小红 > 小刚。这意味着小明 > 小刚。因此,小明比小刚更高。

比较简单,他的能力能应付!

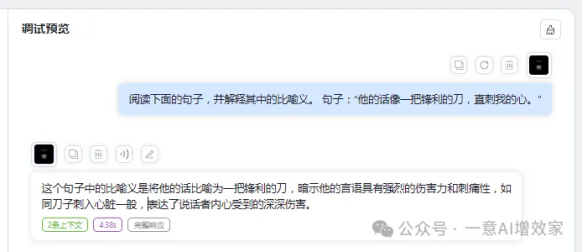

1.3 文本理解

问:阅读下面的句子,并解释其中的比喻义。句子:“他的话像一把锋利的刀,直刺我的心。”

答:这个句子中的比喻义是将他的话比喻为一把锋利的刀,暗示他的言语具有强烈的伤害力和刺痛性,如同刀子刺入心脏一般,表达了说话者内心受到的深深伤害。

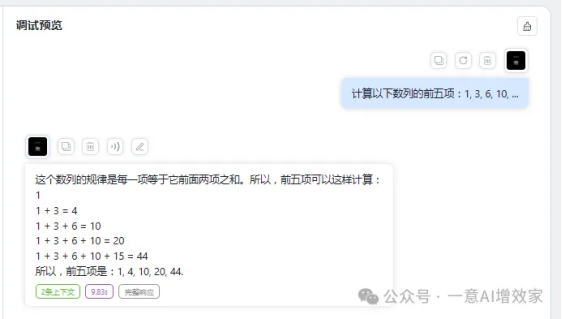

1.4 多步骤计算能力

问:计算以下数列的前五项:1, 3, 6, 10, ...

答:这个数列的规律是每一项等于它前面两项之和。所以,前五项可以这样计算:

1

1 + 3 = 4

1 + 3 + 6 = 10

1 + 3 + 6 + 10 = 20

1 + 3 + 6 + 10 + 15 = 44

所以,前五项是:1, 4, 10, 20, 44.

!!!!不知道你能不能算到?!这是一个推理题!他以为是求和!直接蹦!正确应该是:1-3-6-10-15

1.5 创造性能力

问:请创造一个有趣的童话故事,以“勇敢的小狐狸”为主题。

答:直接看图吧!

总体来说,雄哥觉得,moe灵魂没发挥出来!

多专家协作,不是多个非专模型,干搬砖的事!但!事实证明,模型的结合,也需要智慧和深度!只需要专1件事!

失望!

第二部分:如何部署?需多少算力?

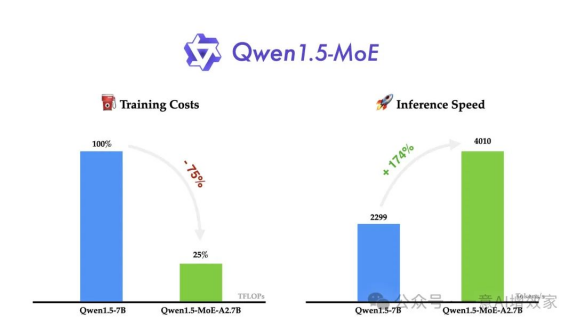

根据官方的说明,它整合了4个总是被激活的共享expert和每次激活其中4个的60个routing expert!

4+4=8!

理论TPS达到4010.27!??

这就是小模型的魔力!

需要多少显存?Qwen1.5-MoE-A2.7B占用显存28G!

int4版本,仅15G!

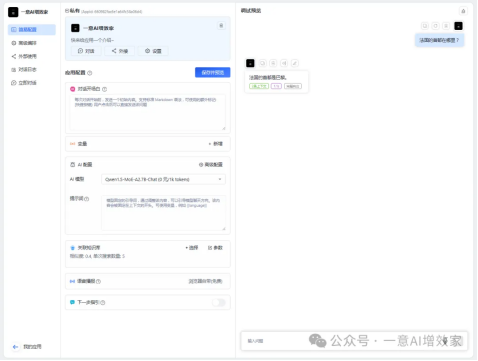

今天,雄哥用vllm来部署一个api!接入fastgpt!不知如何接入,看这!

完全体!本地大模型+知识库大功告成!让知识库可以存知识!fastgpt部署m3e嵌入模型!20/45

现在!打开小企鹅!

如果之前你没用过wsl的,那你要返回去看雄哥之前的方法!

无显卡+纯本地跑Qwen1.5版模型!0基础闭眼部署指南!适用绝大部分开源模型!llama2+Mistral+Zephyr通杀!

创建miniconda环境!

指定名字“moe”,Python版本3.9!

·

conda create --name moe python=3.9

进入环境!

·

conda activate moe

现在!把会员盘下载的“transformers”文件夹复制到“root”目录下!

像这样!

回到刚刚的命令窗!

·

cd transformers

安装vllm+modelscope!否则后面无法下载模型!

·

pip install vllm modelscope --index-url https://pypi.org/simple

设置模型下载源为魔搭!等待上面安装完后,输入,回车!

模型默认保存路径是:/home/edu/.cache/modelscope/hub

·

export VLLM_USE_MODELSCOPE=True

安装transformers!

qwen-moe的代码,只能在源码塑造,所以要源码装一次!

·

pip install --index-url https://pypi.org/simple -e .

至此!环境大功告成!

输入这个指令!系统自动在魔搭下载模型,然后启动推理!

这里,雄哥只用了一块3090显卡,24G显存,但实际模型需要28G,你简单理解一下,就是超出部分使用CPU来推理了!

·

python -m vllm.entrypoints.openai.api_server \

--model qwen/Qwen1.5-MoE-A2.7B-Chat \

--tokenizer qwen/Qwen1.5-MoE-A2.7B-Chat \

--served-model-name Qwen1.5-MoE-A2.7B-Chat \

--max-model-len 4096 \

--gpu-memory-utilization 1 \

--tensor-parallel-size 1 \

--max-parallel-loading-workers 2 \

--enforce-eager

第三部分:模型+代码下载!

价值内容,仅星球会员专享,雄哥把几个版本的模型权重+推理的仓库都上传到会员盘了!

非会员后台回复: “moe”

出自:https://mp.weixin.qq.com/s/ihfqe-FKlxnA3Rc0lmcozA

本文档由网友提供,仅限参考学习,如有不妥或产生版权问题,请联系我们及时删除。

客服请加微信:skillupvip