本文总结了AI领域的多个观点,包括OpenAI的稳定性问题、大模型领域的进步、开源与闭源的差距、LLaMA对大模型生态的影响以及中国研究者的实力。文章认为,尽管OpenAI在某些方面领先,但并非稳如泰山;国内在大模型领域的进步显著,且部分研究者的实力超过外界预期。同时,文章也指出了开源与闭源之间的差距,并强调了数据在模型训练中的重要性。最后,文章对中国在AI领域的发展充满期待。

写在前面

过去一年应该是AI圈最万千瞩目的一年了,大家对大模型、OpenAI、ChatGPT、AI Native、Agent这些词投入了太多的关注,以至于有一年的时间好像经历原本应该两三年才有的科技进步的感觉。近距离看到了老王和光年从风风火火到突发意外,也亲自参与了所谓的“百模大战”,还经历了被人误解的“llama套壳”风波,真的是无比魔幻的一年。回望这一年,太多和大家雷同的观点在这里就不赘述了,记录几个听上去有点反共识的点吧(其实很多也慢慢达成共识了)。

OpenAI没有想象中那么稳

年初去了趟us,拜访了不少OpenAI、Google、Microsoft做大模型相关的researcher和engineer。从us回来的时候,虽然那时国内的大模型赛道因为老王的朋友圈变得异常热闹,但当时内心真实的感觉是国内和OpenAI的差距是巨大的。那时GPT4还没有发布,但硅谷那边几乎所有人都知道GPT4早已经训练完了,将会在几周内发布,而且是chatgpt的重大升级;火爆一时的chatgpt是OpenAI 21年的模型,22年中GPT4就已经训练完成了。而国内则是在研究怎么能在一年内追上chatgpt,再加上之前疫情的影响,国内的researcher和国外的交流是比较匮乏的,有种“信息茧房”的感觉。大模型最重要的三要素:算力、数据、人,国内都不是很ready。不过,当时也看到了OpenAI内部对于AGI和商业化的追求是有明显的差异化的,因为在microsoft的时候有不少research team和product team合作的痛苦经验,深知两个方向所优化的目标是高度不align的。在二月份做了个预测,OpenAI内部关于AGI和商业化的矛盾会在两年内爆发。

年底又去了趟us,回来的时候反而比年初有信心了很多。虽然chatgpt摇摇领先,过去一年,国内虽然说大模型领域一片喧嚣,但不得不说大家的进步是显而易见的,也都训练了很多能力非常不错的基础模型。可以说,国内头部的大模型都已经和chatgpt3.5 comparable了。年初远远低估了国内的云厂商和大公司决策的效率,也低估了大家在大模型领域的投入。所有大模型公司也都找到了追赶期最关键的因素:提高数据数量和数据质量。客观来说,国内在最近一年的进步是比us要大的。

另一方面,OpenAI也没有看起来那么稳。前半年,GPT4快速发布未来模型能力会快速提升;chatgpt用户数据增长很快;plugin好像要重构所有应用。但现在大家都在讨论“scaling law”还能不能持续下去,GPT5可能带来的能力提升是什么;chatgpt用户量增长几乎平了,productivity类的产品会不会有增长天花板,从推理成本来看chatgpt是否真的能盈利;plugin好像已经证明是个彻底的失败了,好在OpenAI 11月6日的开发者大会紧急推出了GPTS,并放了一些新的feature,但能不能大获成功也是个question;如果OpenAI不能持续保持模型的领先力,会不会被to B传统企业和做产品更强的公司给替代掉。

没有“百模大战”

“百模大战”这个词在过去一年被反复提及,但大家似乎混淆了所谓“模型”的概念。大模型应该分为两类,一类是从头开始训练的基础模型,比如:Yi、QWen、Baichuan、ChatGLM、DeepSeek等等;另一类是continue pretraining和sft类别的模型。这两类最大的差别就是花费的资源和训练用的数据。前一类现在大家基本上都是2T左右token起,也有3、4T token的数量级的,这类工作即使训练7B的模型也需要几百万的代价,训练30几B的模型更是数千万的成本。先不管大家模型最终效果如何,至少是花了真金白银做出来的,而且这个是一次训练的成本,还有大量的试错和实验,真实花费代价在几倍以上。后一类variance就比较大了,有用几百B数据做continue pretraining的,也有用几百条数据做sft的,花费则是从几十万到几十块不等。这种情况下,把花费相差5、6个数量级的模型放在一起比较本来就是有失公允的。但如果仔细看“百模大战”里的模型类别,可以发现大多数都是后一类,前一类可能也就十几个,不到二十个。而真正关键的是前一类的基础模型,也是大家真金白银炼出来的模型。

开源和闭源的差距比想象中要大

这个观点其实在之前的文章中有提到过,有兴趣的可以参考。

知乎: https://zhuanlan.zhihu.com/p/644892671

Recall一下几个核心观点:

o 大模型开源的只是权重和模型结构,模型结构大家都相差不大,而更重要的数据和训练方法都没有开源

o 普通开发者很难在大模型预训练过程中参与,更多是在预训练完成后基于模型做posttraining的工作

o LLaMA对国内大模型的生态没有太大影响(仅针对预训练)

关于这些观点和别人产生讨论最多的是LLaMA到底多国内大模型的繁荣有没有帮助。大家都知道LLaMA数据和训练方法都没有开源,只有权重对基础模型训练是一点用处都没有的,大家更想知道模型是怎么训练的,所以唯一有帮助的只有模型架构了。正好我们不幸经历了一场被人误解的“LLaMA套壳”风波(当然,先对改了张量名但没有修正回去等不规范的开源行为道歉),可以展开讲一讲“借鉴架构”的事情。

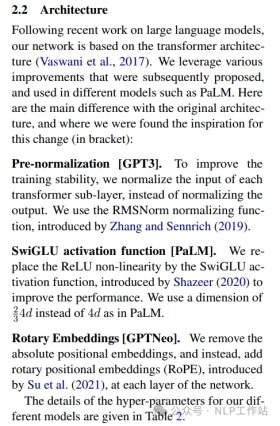

首先看一下什么是所谓的LLaMA的架构,或者说这是不是一个可以固化的概念。下面是LLaMA paper中关于architecture的全部篇幅,在双栏paper中只占1/4页。

架构说了模型是基于transformer架构,做了三个常用的改进,分别是pre-norm,SwiGlue和RoPE。再回顾看看在ChatGPT发布前,或者说LLaMA发布前大家是怎么训练大模型的,无论是GPTNeoX,BloomZ还是Galectica,基本都是一样的架构,和LLaMA架构基本没有区别。所以,只要是之前训练大模型的人,大家都知道训练大模型的架构应该是什么样子的。大家不知道的是用高质量的数据原来能训练出一个还不错的模型,因为之前的数据质量问题,用同样架构并没有训练出效果出众的模型。但当LLaMA出来之前大家开始做大模型的时候,但凡稍微有点大模型背景的研究人员早就已经把数据提高到了第一优先级。所以,“借鉴架构”的概念是很难成立的,因为LLaMA本身就不能被称为一种架构,或者说LLaMA出来之前大模型架构已经收敛了。LLaMA更多是给了大家信心和敢于投入的勇气,从这点来说还是有很大帮助的。

中国的researcher比想象中要强

经常听到一个观点,世界上做大模型最强的100个人,有95个以上在美国。所以只要从OpenAI挖几个人或者从Google挖几个人,就能做出世界领先的大模型了。但过去一年有幸接触了几乎所有国内做大模型的团队,也看到了很多原来在其他研究领域做出过突出成就的研究员在大模型赛道上突飞猛进,还有一些有潜力的学生/new graduate在被信任的环境下做出了比那些有经验的“大厂工程师”数倍的成果。所以做大模型还是需要相信最优秀的那批人和相信年轻人。之前大家认为国内的researcher不适合做大模型,只是因为国内没有给大家创造一个可以用几千卡联合训练模型的环境。但当去年有了这种条件以后,国内的前沿工作者的迭代速度是明显超过国外的,这也是某种意义上国内去年模型能力快速提高地核心原因。毕竟,训练大模型只需要少数非常精英的人,给每人大几千张卡去做实验,剩下的就是做好support就有可能成功。人越多,反而效率越低。这个对管理者的人才识别能力和对人才的信任就是很大的考验。如果现在要问我世界上做大模型最强的100个人,我觉得有一半以上是在中国。

最后,quote 老王的一句话,在AGI的路上,所有参与者都是朋友。很期待中国今年能做出GPT4 comparable的基础模型。

出自:https://mp.weixin.qq.com/s/qOkxq5xsRd6dM2TK2p6Wrg

本文档由网友提供,仅限参考学习,如有不妥或产生版权问题,请联系我们及时删除。

客服请加微信:skillupvip